Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.

-

Die CPU ist nicht schlecht. 4 echte Cores, da ist kein Engpass, wenn eine VM wirklich mal die beiden zugewiesenen vCPUs beansprucht.

Mit den 8 GB kannst du natürlich nicht einigen VMs großzügig RAM zuteilen, sollte aber reichen. Ggf. KSM aktivieren.

Die beiden

-FTP- und Fileserver für die IP-Cams im Security-Subnet,

-Datengrab der Familie im LAN-Subnet

betreibst du ja vermutlich auf einer VM. Der Unify Controller sollte nicht viel RAM benötigen, der Zabbix Server wird auch mit 2 GB das Auslangen finden. Von deiner Home Automation hab ich keine Ahnung.Noch RAM-sparender ginge es, wenn du einiges in Container packst.

-

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Die beiden

-FTP- und Fileserver für die IP-Cams im Security-Subnet,

-Datengrab der Familie im LAN-Subnet

betreibst du ja vermutlich auf einer VMVM ist noch absolutes Neuland, da ist einlesen angesagt.

Der Family-Fileserver ist extra, die IP-Cams lagern ihre Bilderchen und Videos aktuell auf dem Host mit dem Unifi Controller ein. Da looft auch noch der Zappix Server und aktuell openHAB2 drauf.

Vorher war openHAB auf einer RPI 3 installiert, das lief recht geschmeidig. Leider ist die RPI 3 gestorben, und eine RPI 2 ist damit überfordert. Würde somit einfach mal behaupten, eine openHAB Instanz würde mit 1 GB RAM laufen, so wie der Fileserver der IP-Cams auch.

Der Familyserver beansprucht zur Zeit knapp 600MB RAM, kann eventuell mehr werden, wenn Daten durchs LAN geschoben werden, bin mir da so nicht sicher.Die Sache ist die, alle Devices schieben ihre Daten kreuz und quer durch die verschiedenen Subnetze, das ist irgendwie uncool und das möchte ich irgendwie vermeiden. Also Fileserver der IP-Cams bleibt im Security-Subnet, Unifi Controller bleibt für sich MGMT-Netz, Family Server im LAN, Home Automation im IoT, usw...

Klar, es ist möglich alle Services auf ein Host zu klatschen und mit VLANs zu hantieren, weil für openHAB und Mediastreaming wird Multicast benötigt, auch irgendwie blöd.

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Noch RAM-sparender ginge es, wenn du einiges in Container packst.

Meinst du sowas wie Docker?

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen.:

Meinst du sowas wie Docker?

Linux Container (LXC). Das kann auch Proxmox.

Ist ähnlich wie Docker, eine Applikations-Isolierung. Es werden die Ressourcen des Hosts verwendet, nur das, was die Applikation verändern muss, wird für diese isoliert.

Macht halt nur Sinn, wenn alles dieselbe Basis verwendet. Das spart RAM und Plattenplatz.

Ich habe damit aber auch noch keine Erfahrung gesammelt.Wenn dieselbe Basis auf mehreren VMs verwendet wird (bspw. Linux Kernel) ist aber auch KSM ein wundersamer RAM-Verfielfacher, kostet aber etwas CPU-Leistung.

-

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Wenn dieselbe Basis auf mehreren VMs verwendet wird

Auf alle Fälle, wird eine aktuelle Debian Distro sein.

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Linux Container (LXC). Das kann auch Proxmox.

Schau mir das mal an.

Danke erstmal.

-

Würde auch Proxmox VE mit Containern machen. Rockt für zu Hause.

Hab mir dad gerade mit 2 Nodes auf 2 NUCs gebaut mit 256er SSDs und jeder 8GB RAM. Reicht mir Container völlig, gerade Sachen wie FTP o.a. brauchen ja keinen Container mit viel Storage. Und mit ZFS installiert gehen auch platzsparende Snapshots und CoEdit: ah die NUCs sind auch nur Celerons aber hey im Ernst bis auf den Zabbix les ich nichts was hart CPU lastig ist. Die sind trotzdem schneller als nen Raspi 2, 3 o.ä. und nen Pi4 braucht mitunter auch Strom wie nen NUC oder kleiner Celeron.

Aber deshalb werde ich baldmöglichst mit der neuen Hardware nen Stream oder Meeting machen weil ich da auch überlege, Proxmox raufzuhauen um mehrere Sachen zu machen.

-

Proxmox hat KSM standardmäßig aktiviert, habe ich gerade gesehen.

Na dann sollte der RAM nicht zu eng werden. -

Die CPU wird mehr können viel mehr.

Ist ja ein Skylake Unterbau oder neuer wenn ich nicht irre.

Mein NAS soll auch nur 8GB können (J3455) rennt seit fast 2 Jahren mit 16 rum.VLANs und Multicast wo ist das Problem? Habe ich hier in allen aktiv aber nur in 2 ist ein Switch als Querier aktiv und das funktioniert einfach perfekt.

Ist der Switch nicht da brauche ich auch kein MC. -

@NOCling said in Hardware zur Virtualisierung von mehreren Instanzen.:

Mein NAS soll auch nur 8GB können (J3455) rennt seit fast 2 Jahren mit 16 rum.

Wie?

16 GB RAM in den einzigen vorhandenen Slot reingesteckt?Intel gibt doch selbst für diese CPU an, nur 8 zu unterstützen.

-

Moinsen.

Erstmal danke fürs Feedback.

Habe in den letzten 2 Tagen am Proxmox Server geschraubt, Thinkpads Ultrabay sei Dank. :)

Zweite HDD rein, Proxmox VE installiert, gestartet und 5 LXC mit Debian Buster erzeugt. So kann ich alles vorkonfigurieren, brauche dann nur die HDD tauschen, so der Plan.@NOCling said in Hardware zur Virtualisierung von mehreren Instanzen.:

VLANs und Multicast wo ist das Problem?

3 Instanzen laufen in versch. Netzwerken. Gibt es da ein HowTo dazu? Weiss noch nicht richtig, wie es unter Proxmox konfiguriert wird.

@NOCling said in Hardware zur Virtualisierung von mehreren Instanzen.:

Mein NAS soll auch nur 8GB können (J3455) rennt seit fast 2 Jahren mit 16 rum.

Wird auch bei Alternate und Amazon so angegeben. Intel schreibt was anderes, traut seiner Hardware nicht viel zu. :)

-

Du sollst dann bei Intel halt einen i3, i5, i7 oder schlimmer kaufen und keinen Celeron.

Mein NAS hat 2 Plätze und in jedem steckt ein 8GB Riegel. Es hat aber auch schon einer zwei 16er rein gesteckt und seine Kiste läuft auch damit stabil.Was die VM Umgebung angeht, du legst wie auf dem Switch halt die VLANs an, packst die tagged auf die ESXi Uplinks drauf und kannst die VMs dann an diese Virtuellen Adapter inkl. VLAN ID anbinden.

Multicast braucht halt einen Querier, hängt vom Switch ab wie man das lösen kann.

Ein VLAN Interface mit einer IP geht immer, bei anderen kann man das mit einer Loopback IP lösen die als Querier läuft und bei anderen muss man für das Interface noch die L3 Funktion abschalten.Ist halt immer Modell/Herstellerabhängig.

Damit es richtig gut läuft querier interval time auf 60 Sekunden und dann hast nie wieder MC Probleme wenn nicht ein Problem mit der Multicastimplementierung beim Modell/Firmware selber vorliegt.

VLAN ID : 13

VLAN Name : xx

IGMP version : 2

Querier Address [this switch] : 192.168.13.6

Querier Port :

Querier UpTime : 74d 22h 43m 43s

Querier Expiration Time : 0h 0m 4sActive Group Addresses Type Expires Ports Reports Queries

239.12.0.78 Filter 0h 1m 17s 22 3211 0

239.12.0.231 Filter 0h 1m 19s 20 400 0

239.12.1.114 Filter 0h 1m 21s 21 115306 0

239.12.1.116 Filter 0h 1m 22s 20 400 0

239.12.1.122 Filter 0h 1m 19s 22 3211 0

239.12.255.253 Filter 0h 1m 21s 20-22 346405 16

239.12.255.254 Filter 0h 1m 21s 20-22 346398 16

239.12.255.255 Filter 0h 1m 21s 21-22 230612 1

239.170.0.1 Filter 0h 1m 18s 20 7481 0

239.255.255.250 Filter 0h 1m 20s 20 7481 0 -

Moin.

Sorry, Hardware hat den Geist aufgegeben, es konnte gestern erst weitergehen.

@NOCling

Das VLAN Konfiguration war nicht wirklich das Problem, es lag an den Rules der pfSense. Zu viele Stunden vor dem Monitor gesessen und das einfachste übersehen.

Zu viele Stunden vor dem Monitor gesessen und das einfachste übersehen.Habe jetzt noch Sachen zum Thema PVE:

Werde alle 5 Min aus der WebGUI gekickt und kann mich neu anmelden, inkl. der Meldung des nicht vorhandenen Subscription Key. Das nervt irgendwie, kann es auch an den gleichzeitigen Zugriff per CLI und der WebGUI liegen?

Zum zweiten, wie werden andere Laufwerke den VMs soweit zugänglich gemacht, dass sie darauf kompletten Zugang haben und z.B. lesen und schreiben können? Die gemounteten LW lassen sich als Directory in pve einbinden, leider nur für Disk Images, VM Images, Snapshots usw..., nicht als "normale" LW bzw Ordner für die VMs. Zumindest habe ich es noch nicht gefunden.

Eine mit QEMU erstellten VM können zumindest paar Shared Folder erzeugen werden, sollte für pve auch möglich sein, oder?

Falls das kicken aus der WebGUI politischer Natur ist, wird unsere Freundschaft eh bald ein Ende haben.

Gruß, Mike

-

@mike69

Mit PVE muss man erst zusammenfinden. Hat bei mir auch Monate gedauert, in denen ich bereut hatte, nicht einfach VMM +SSH (für die Remote-Wartund) installiert zu haben, der mir bereits vertraut war.

Jetzt denke ich gar über ein Upgrade auf Version 6 nach.

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen.:

Werde alle 5 Min aus der WebGUI gekickt und kann mich neu anmelden

Das Problem kenne ich nicht. Das kann bei der 6er Version auch nicht normal sein.

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen.:

Zum zweiten, wie werden andere Laufwerke den VMs soweit zugänglich gemacht, dass sie darauf kompletten Zugang haben und z.B. lesen und schreiben können?

Was meinst du damit?

Den VMs Laufwerke hinzufügen? Das ist ja bei KVM auch so. Oder meinst du Zugriff auf Netzlaufwerke? -

Na Du machst einem Mut.

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Das Problem kenne ich nicht. Das kann bei der 6er Version auch nicht normal sein.

Ja, kam erst paar Tage später, so am 3ten Tag. War auch gleichzeitig per CLI im Gange, eventuell mag pve so was nicht.

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Den VMs Laufwerke hinzufügen? Das ist ja bei KVM auch so. Oder meinst du Zugriff auf Netzlaufwerke?

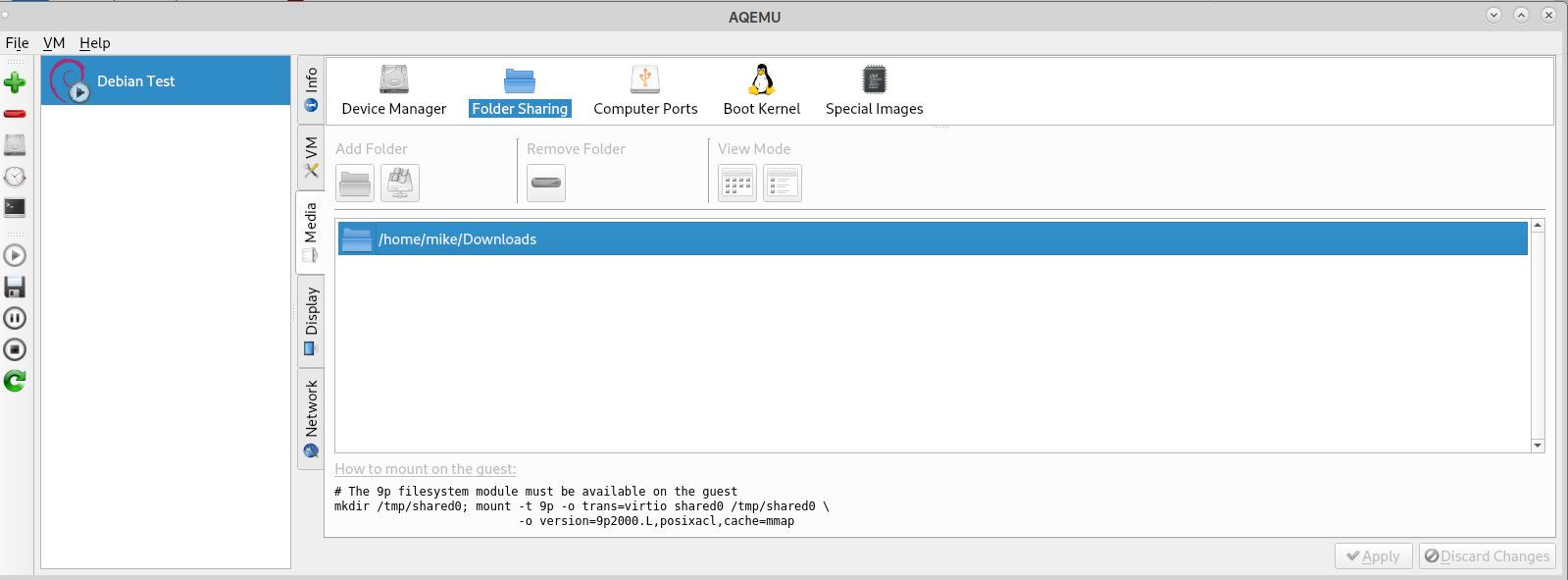

Keine Laufwerke, sondern gemeinsame freigegebene Ordner auf dem Host. Möchte einer VM die Möglichkeit geben, in einem Ordner auf dem Host zu schreiben. Wird unter aqemu als "shared folder" bezeichnet.

Habe paar Lösungsansätze gefunden, musst per CLI die richtige vm.conf editieren.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen.:

Möchte einer VM die Möglichkeit geben, in einem Ordner auf dem Host zu schreiben. Wird unter aqemu als "shared folder" bezeichnet.

Nun hab ich was dazugelernt.

Seit fast 10 Jahren beschäftige ich mich mit Qemu + KVM, aber das hatte ich noch nicht verwendet.Nein, ich denke nicht, dass pve das bietet, nicht in der GUI.

-

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Nein, ich denke nicht, dass pve das bietet, nicht in der GUI

Stimmt, per CLI

Oder etwas älter hierWerde beizeiten mal testen. Oder switche komplett auf qemu und ssh um, mal sehen. Bin noch für alles offen :)

-

So, es geht langsam weiter hier.

Die Überschrift ist angepasst, es geht ja aktuell nicht nur um die Hardware. :)

Habe jetzt die DVB-S2 PCIe Satkarte zum Clienten durchgeschleift, siehe hier als Beispiel oder hier. TVHeadend erkennt die Tuner, alles tutti.

Als nächstes wird die Aktion mit den freigegebenen Ordnern auf dem Host in Angriff genommen.

Hier noch paar Infos zu dem Thema "folder sharing", nutze selber AQEMU als GUI auf dem Notebook und es wird Dir sogar der Mountbefehl angezeigt. :)

-

@mike69

Danke.9P Filesystem? Auch noch nie gehört.

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

nutze selber AQEMU als GUI auf dem Notebook und es wird Dir sogar der Mountbefehl angezeigt. :)

Wie gesagt, ich verwende seit jeher VMM, dieser bietet das auch als "Filesystem Passthrough", vielleicht mit einigen Optionen mehr, aber beim mounten lässt der einen im Regen stehen. Dafür darf man dann seine Suchmaschine anwerfen.

Aktuell habe ich aber für das keine Verwendung, abgesehen von einer Windows VM, aber da lässt sich das FS vermutlich gar nicht mounten, also verwende ich Samba für die paar Dateiübertragungen.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Werde alle 5 Min aus der WebGUI gekickt und kann mich neu anmelden, inkl. der Meldung des nicht vorhandenen Subscription Key. Das nervt irgendwie, kann es auch an den gleichzeitigen Zugriff per CLI und der WebGUI liegen?

Der Kick aus der WebGUI kann sein, dass die Uhr des Proxmox nicht korrekt läuft. Hatte ich anfangs auch, nach 1-2 Tagen und aktivem NTP hat sich das erledigt gehabt. Weiß aber nicht obs wirklich daran lag.

inkl. der Meldung des nicht vorhandenen Subscription Key

PVE auf Community Quellen umgestellt? Dann kannste die Meldung mit ein zwei Zeilen Code problemlos ausknipsen. Ging mir bei meinem Testcluster aus 2 NUCs auch auf die Nerven. Jetzt ist Ruhe. :)

-

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Der Kick aus der WebGUI kann sein, dass die Uhr des Proxmox nicht korrekt läuft. Hatte ich anfangs auch, nach 1-2 Tagen und aktivem NTP hat sich das erledigt gehabt. Weiß aber nicht obs wirklich daran lag.

Also gestern war Ruhe, kein Kick. Komm jetzt langsam weiter mit dem freigeben der Ordner.

Eintrag in die 1xx.conf:

args: -fsdev local,security_model=passthrough,id=fsdev0,path=/pve/own/folder/ -device virtio-9p-pci,id=fs0,fsdev=fsdev0,mount_tag=9p_data,bus=pci.0,addr=0x4Und auf der VM in /etc/fstab:

9p_data /vm/own/folder 9p trans=virtio,version=9p2000.L,rw,_netdev 0 0So ist ein geteilter Ordner freigegeben. Brauche aber 3 Ordner, da scheitert es an der Syntax irgendwie. Oder verlinke alle benötigten Ordner zu einem zentralen Ordner auf dem Host, brauche dann nur eine Freigabe. :)

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

PVE auf Community Quellen umgestellt? Dann kannste die Meldung mit ein zwei Zeilen Code problemlos ausknipsen. Ging mir bei meinem Testcluster aus 2 NUCs auch auf die Nerven. Jetzt ist Ruhe. :)

Ist auf Community geswitched

Los, make my Day.

Wo sitzt die verdammte .js Datei? Gib mir ein Link.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Also gestern war Ruhe, kein Kick. Komm jetzt langsam weiter mit dem freigeben der Ordner.

Was ist da genau der Sinn und wo liegt der Ordner der freigegeben ist? Warum nicht einfach als bspw. NFS shared folder einbinden?

Los, make my Day.

Moment, muss das andere Laptop anwerfen.