Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.

-

@mike69

Mit PVE muss man erst zusammenfinden. Hat bei mir auch Monate gedauert, in denen ich bereut hatte, nicht einfach VMM +SSH (für die Remote-Wartund) installiert zu haben, der mir bereits vertraut war.

Jetzt denke ich gar über ein Upgrade auf Version 6 nach.

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen.:

Werde alle 5 Min aus der WebGUI gekickt und kann mich neu anmelden

Das Problem kenne ich nicht. Das kann bei der 6er Version auch nicht normal sein.

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen.:

Zum zweiten, wie werden andere Laufwerke den VMs soweit zugänglich gemacht, dass sie darauf kompletten Zugang haben und z.B. lesen und schreiben können?

Was meinst du damit?

Den VMs Laufwerke hinzufügen? Das ist ja bei KVM auch so. Oder meinst du Zugriff auf Netzlaufwerke? -

Na Du machst einem Mut.

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Das Problem kenne ich nicht. Das kann bei der 6er Version auch nicht normal sein.

Ja, kam erst paar Tage später, so am 3ten Tag. War auch gleichzeitig per CLI im Gange, eventuell mag pve so was nicht.

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Den VMs Laufwerke hinzufügen? Das ist ja bei KVM auch so. Oder meinst du Zugriff auf Netzlaufwerke?

Keine Laufwerke, sondern gemeinsame freigegebene Ordner auf dem Host. Möchte einer VM die Möglichkeit geben, in einem Ordner auf dem Host zu schreiben. Wird unter aqemu als "shared folder" bezeichnet.

Habe paar Lösungsansätze gefunden, musst per CLI die richtige vm.conf editieren.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen.:

Möchte einer VM die Möglichkeit geben, in einem Ordner auf dem Host zu schreiben. Wird unter aqemu als "shared folder" bezeichnet.

Nun hab ich was dazugelernt.

Seit fast 10 Jahren beschäftige ich mich mit Qemu + KVM, aber das hatte ich noch nicht verwendet.Nein, ich denke nicht, dass pve das bietet, nicht in der GUI.

-

@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen.:

Nein, ich denke nicht, dass pve das bietet, nicht in der GUI

Stimmt, per CLI

Oder etwas älter hierWerde beizeiten mal testen. Oder switche komplett auf qemu und ssh um, mal sehen. Bin noch für alles offen :)

-

So, es geht langsam weiter hier.

Die Überschrift ist angepasst, es geht ja aktuell nicht nur um die Hardware. :)

Habe jetzt die DVB-S2 PCIe Satkarte zum Clienten durchgeschleift, siehe hier als Beispiel oder hier. TVHeadend erkennt die Tuner, alles tutti.

Als nächstes wird die Aktion mit den freigegebenen Ordnern auf dem Host in Angriff genommen.

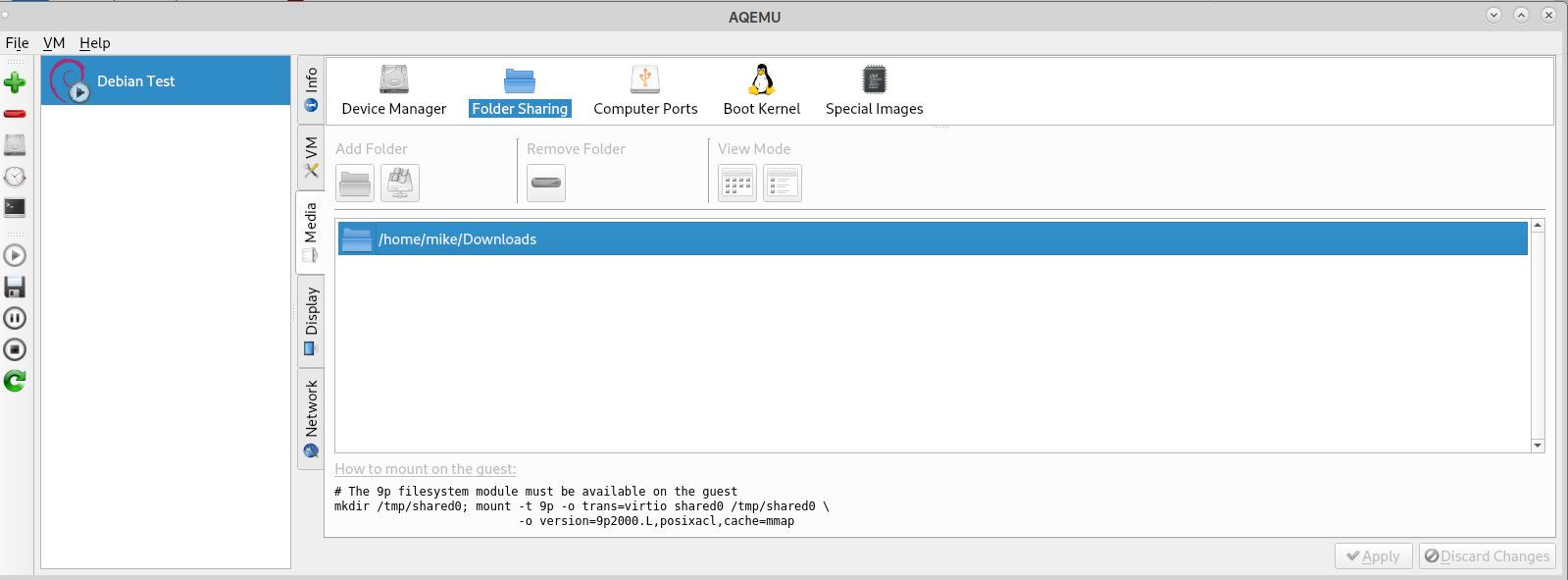

Hier noch paar Infos zu dem Thema "folder sharing", nutze selber AQEMU als GUI auf dem Notebook und es wird Dir sogar der Mountbefehl angezeigt. :)

-

@mike69

Danke.9P Filesystem? Auch noch nie gehört.

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

nutze selber AQEMU als GUI auf dem Notebook und es wird Dir sogar der Mountbefehl angezeigt. :)

Wie gesagt, ich verwende seit jeher VMM, dieser bietet das auch als "Filesystem Passthrough", vielleicht mit einigen Optionen mehr, aber beim mounten lässt der einen im Regen stehen. Dafür darf man dann seine Suchmaschine anwerfen.

Aktuell habe ich aber für das keine Verwendung, abgesehen von einer Windows VM, aber da lässt sich das FS vermutlich gar nicht mounten, also verwende ich Samba für die paar Dateiübertragungen.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Werde alle 5 Min aus der WebGUI gekickt und kann mich neu anmelden, inkl. der Meldung des nicht vorhandenen Subscription Key. Das nervt irgendwie, kann es auch an den gleichzeitigen Zugriff per CLI und der WebGUI liegen?

Der Kick aus der WebGUI kann sein, dass die Uhr des Proxmox nicht korrekt läuft. Hatte ich anfangs auch, nach 1-2 Tagen und aktivem NTP hat sich das erledigt gehabt. Weiß aber nicht obs wirklich daran lag.

inkl. der Meldung des nicht vorhandenen Subscription Key

PVE auf Community Quellen umgestellt? Dann kannste die Meldung mit ein zwei Zeilen Code problemlos ausknipsen. Ging mir bei meinem Testcluster aus 2 NUCs auch auf die Nerven. Jetzt ist Ruhe. :)

-

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Der Kick aus der WebGUI kann sein, dass die Uhr des Proxmox nicht korrekt läuft. Hatte ich anfangs auch, nach 1-2 Tagen und aktivem NTP hat sich das erledigt gehabt. Weiß aber nicht obs wirklich daran lag.

Also gestern war Ruhe, kein Kick. Komm jetzt langsam weiter mit dem freigeben der Ordner.

Eintrag in die 1xx.conf:

args: -fsdev local,security_model=passthrough,id=fsdev0,path=/pve/own/folder/ -device virtio-9p-pci,id=fs0,fsdev=fsdev0,mount_tag=9p_data,bus=pci.0,addr=0x4Und auf der VM in /etc/fstab:

9p_data /vm/own/folder 9p trans=virtio,version=9p2000.L,rw,_netdev 0 0So ist ein geteilter Ordner freigegeben. Brauche aber 3 Ordner, da scheitert es an der Syntax irgendwie. Oder verlinke alle benötigten Ordner zu einem zentralen Ordner auf dem Host, brauche dann nur eine Freigabe. :)

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

PVE auf Community Quellen umgestellt? Dann kannste die Meldung mit ein zwei Zeilen Code problemlos ausknipsen. Ging mir bei meinem Testcluster aus 2 NUCs auch auf die Nerven. Jetzt ist Ruhe. :)

Ist auf Community geswitched

Los, make my Day.

Wo sitzt die verdammte .js Datei? Gib mir ein Link.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Also gestern war Ruhe, kein Kick. Komm jetzt langsam weiter mit dem freigeben der Ordner.

Was ist da genau der Sinn und wo liegt der Ordner der freigegeben ist? Warum nicht einfach als bspw. NFS shared folder einbinden?

Los, make my Day.

Moment, muss das andere Laptop anwerfen.

-

So das hat bei mir aktuell super funktioniert:

Credits: Das war aus einem Github GIST - ich denke dem hier:

https://gist.github.com/whiskerz007/53c6aa5d624154bacbbc54880e1e3b2a## Proxmox VE Community installieren # Disable Commercial Repo sed -i "s/^deb/\#deb/" /etc/apt/sources.list.d/pve-enterprise.list apt update # Add PVE Community Repo echo "deb http://download.proxmox.com/debian/pve $(grep "VERSION=" /etc/os-release | sed -n 's/.*(\(.*\)).*/\1/p') pve-no-subscription" > /etc/apt/sources.list.d/pve-no-enterprise.list apt update # Remove nag screen for homelab use echo "DPkg::Post-Invoke { \"dpkg -V proxmox-widget-toolkit | grep -q '/proxmoxlib\.js$'; if [ \$? -eq 1 ]; then { echo 'Removing subscription nag from UI...'; sed -i '/data.status/{s/\!//;s/Active/NoMoreNagging/}' /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js; }; fi\"; };" > /etc/apt/apt.conf.d/no-nag-script apt --reinstall install proxmox-widget-toolkitDer letzte Punkt ist der Knackpunkt. Also die beiden Zeilen. Die eine richtet ein Post-Invoke ein, der theoretisch jedes Mal nach einem package Update vom Widget Toolkit ausgeführt wird. Also nach Installation/Update sollte der dann getriggert werden. Bei einer aktuellen Version dann einfach nochmal den APT mit --reinstall der zweiten Zeile ausführen, dadurch wird das Paket nochmals drüberinstalliert und der Trigger ausgelöst und der JS Nagscreen entfernt.

Prinzipiell bin ich nicht gegen sowas, die wollen ja mit dem Support auch was Sinnvolles anfangen, aber für ein Homelab, wo ich definitiv nur rumspiele und teste, macht es eher wenig Sinn, dass ich da eine Subscription kaufen werden (wir haben ja eine auf Arbeit) zumal ich da gerade ja Bleeding Edge Pakete testen will ;)

-

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Was ist da genau der Sinn und wo liegt der Ordner der freigegeben ist? Warum nicht einfach als bspw. NFS shared folder einbinden?

Habe paar HDDs im Gehäuse und einige LW gemounted für versch. Scenarien, Backup, Datengrab für Family, kleines RAID für Mediafiles, usw..., alles auf dem Host. Bevor ich mich komplett auf KVM oder VMs whatever einschiesse, und alles in Container verschwinden lasse, soll der Zugriff auf die Shares vorhanden sein. Ist ja auch nur die Mediaserver-VM, die das braucht, und die Backupserver-VM die benötigt ein Share und das funzt schon.

Zu NFS, eigendlich egal, welches Protokoll genutzt wird. Ein NFS-Server ist eh vorhanden, wollte es nur anders hin bekommen, NFS oder SMB wäre Plan B und C.

Danke für den Link, @JeGr , muss gleich ackern, schaue heute Abend mal rein.

PS:

Die VMs mucken gelegendlich, wenn sie über die GUI gestoppt oder rebootet werden, liegt an der .lock Datei. Nervt ein bisschen. Bei Dir auch?So, erstmal wech...

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Zu NFS, eigendlich egal, welches Protokoll genutzt wird. Ein NFS-Server ist eh vorhanden, wollte es nur anders hin bekommen, NFS oder SMB wäre Plan B und C.

Ahso na dann :)

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Die VMs mucken gelegendlich, wenn sie über die GUI gestoppt oder rebootet werden, liegt an der .lock Datei. Nervt ein bisschen. Bei Dir auch?

Bislang nicht

Bin aber auch noch nicht zu viel gekommen. Und neustarts oder reboots mache ich eigentlich wann immer es geht in der VM/Container selbst. Schon allein damit die Prozesse alles ordentlich mitbekommen. Oldschool halt ;) -

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Die VMs mucken gelegendlich, wenn sie über die GUI gestoppt oder rebootet werden, liegt an der .lock Datei.

Den Guest Channel hast du hinzugefügt und den Agent in der VM installiert?

Ansosnten wird das über ACPI gemacht, was nicht immer zum Erfolg führt. -

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

So das hat bei mir aktuell super funktioniert:

Credits: Das war aus einem Github GIST - ich denke dem hier:

https://gist.github.com/whiskerz007/53c6aa5d624154bacbbc54880e1e3b2aJau, hat funktioniert, danke. :)

Zum Thema NFS Freigaben:

Ja, kannst du mounten im Datacenter, aber nur als Plattform für die Images, Clones, usw, nicht als richtige Freigabe von Ordnern. Oder übersehe was, k. A..@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Den Guest Channel hast du hinzugefügt und den Agent in der VM installiert?

Bei der VM nicht, danke. :)

Beim Rest war es installiert, da klappte es auch.

So, der Mediaserver funzt, jetzt kann der/die? :) Node weiter laufen. Den Rest hole ich nach und nach auf den Host, das hat keine Eile.

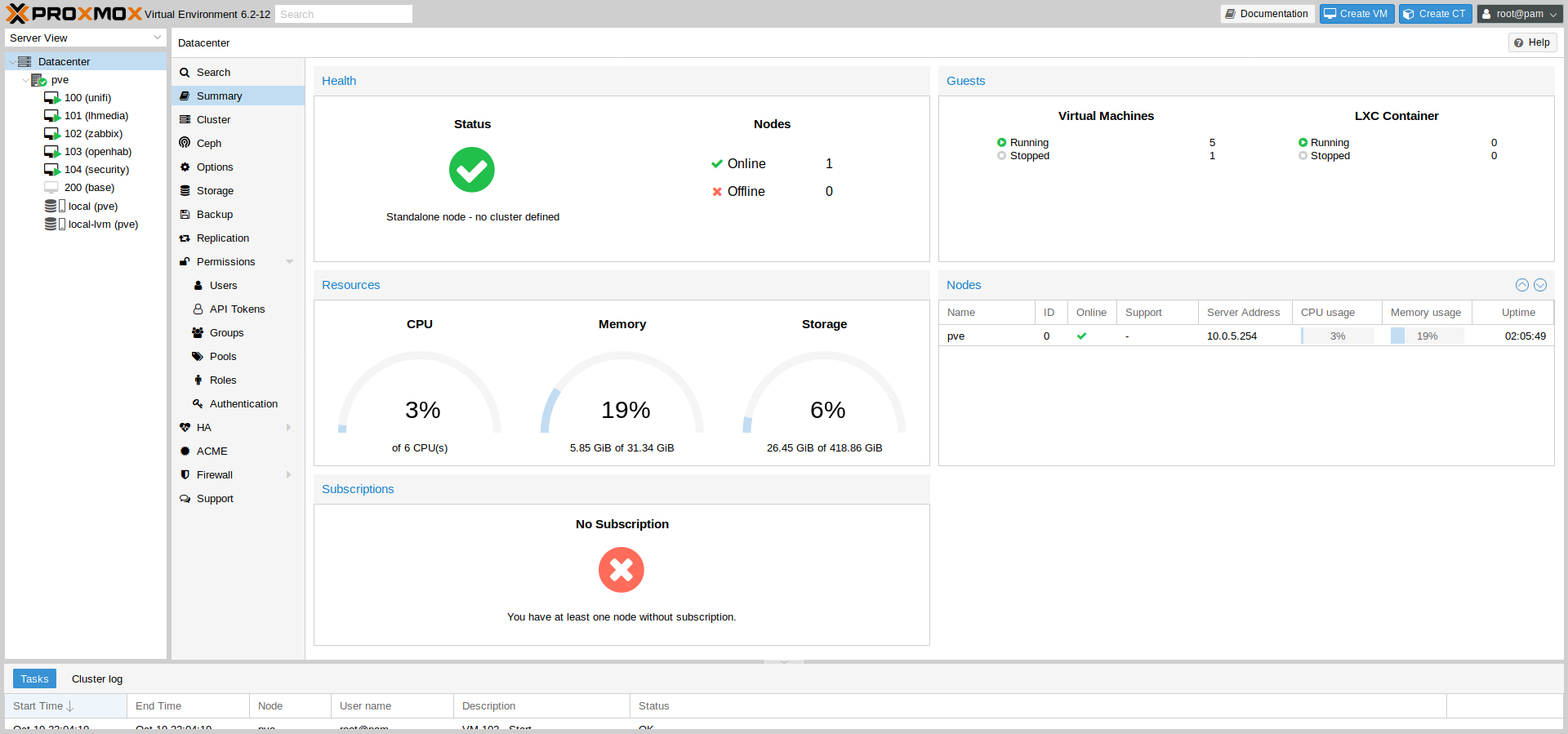

Hier ein Pic von 5 laufenen VMs:

Edit:

Moinsen.

Looft doch nicht wie es soll, nfs verträgt sich nicht mit dem 9p. Sind erst die Ordner vom host in dem Guest System gemountet, startet der NFS Server unter Guest nicht. Erst NFS Server starten und dann die händisch Hostordner mounten, das klappt. :(Das ist doch wieder alles mit der heissen Nadel gestrickt hier.

-

Ich komm da jetzt eher zu arg aus der Virtualisierungs-Ecke mit VMware, Xen und Co. von früher, aber:

warum nicht hergehen, eine VM oder Container erstellen mit einer kleinen Hauptplatte und dann einer zusätzlichen "Platte" die dann freigegeben wird per NFS? Da kann man IMHO sicherlich nen ext4 o.ä. Image einbinden, was die VM dann einhängen und per NFS den anderen Containern freigeben kann. Und wenn die NFS VM/Container aus ist, kann mans notfalls auch auf dem Host selbst mounten weils ein einfaches ext4 image ist. Ich hab das noch irgendwie im Hinterkopf dass das gehen müsste. Ich bin da nämlich nicht so der Fan, dass VMs oder Container "ausbrechen" dürfen und direkt an den Host ran dürfen. Am Ende bekommen sie da irgendwie ne Shell und können ausbüchsen - nene ;) So würde ichs versuchen zu lösen aber ob/wie das jetzt auf die schnelle mit Proxmox geht müsste ich auch nachsuchen. Leider momentan zu wenig Zeit mit Nacharbeit durch Krankheit und Co.

-

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Ich komm da jetzt eher zu arg aus der Virtualisierungs-Ecke mit VMware, Xen und Co. von früher, aber:

warum nicht hergehen, eine VM oder Container erstellen mit einer kleinen Hauptplatte und dann einer zusätzlichen "Platte" die dann freigegeben wird per NFS? Da kann man IMHO sicherlich nen ext4 o.ä. Image einbinden, was die VM dann einhängen und per NFS den anderen Containern freigeben kann.Die Container oder VMs brauchen nicht miteinander quatschen, bis auf den Mediaserver braucht keiner Zugriff auf den Host. Eventuell noch der Backupserver, dem kann man virtuell was zuweisen, das ist nicht das Problem.

Proxmox und ich sind noch nicht so dicke, als dass alles komplett auf Virtual umgeswitched wird. Das Backup und Restore wird Tage dauern, nur um Proxmox zu testen viiiiel Aufwand. :)

Ziehst ja nach dem ersten zwei Dates auch nicht gleich bei der Braut ein.

Fange ja bei Null an, bin jetzt soweit, dass ein Container den Mediaserver und NAS übernimmt. Da sind 3 Shares gemountet und damit können die Kodiboxen befeuert werden. Mit einer VM klappte nur ein Share zu mounten. Mehr geht hier aktuell nicht, wer was dazu sagen kann, wie mehrere gemountet werden kann, bitte.

Aktuell über smb, da nfs keine virtuellen Shares verteilen kann, nur physikalische Devices wie HDDs oder optische LWe etc. Mit Samba geht es, warum, keine Ahnung.Leider bin Ich nicht in der Lage, im Container die PCIe Satkarte anzusprechen, Sehe unter dmesg was, sieht aber aus wie die Einträge vom Host. Bleibt nur eine VM mit durchgereichter PCIe Karte. Ob das funzt, keine Ahnung.

Soweit die Lage, Jens. Und, wie war deine Woche so?

-

Nabend.

So, ein kleines Feedback.

Die Mediaserver VM greift nun auf mehrere Shares vom Host zu. Die Sat>IP Server VM mit der durchgereichten Sat-Karte looft, pumpt die Aufnahmen auf ein gemeinsamen Ordner, wo der Mediaserver darauf zugreifen kann. Die anderen kleinen VMs sind so gut wie konfiguriert, kann jetzt nach und nach die anderen Buden abschalten. :)

Hab auch langsam die Fresse dick.

@JeGr

Die Nodes unter PVE können sich per acme und Letsencrypt Zertifikate erstellen lassen, schon zum laufen bekommen? -

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Die Nodes unter PVE können sich per acme und Letsencrypt Zertifikate erstellen lassen, schon zum laufen bekommen?

Du meinst die PVE Nodes also der Hypervisor selbst? Ja hab ich. Meine haben sich beide als hvn01/hvn02 ein Zert ausgestellt :) Zusätzlich läuft davor noch ein HAproxy mit Prio auf hvn01 der aber auf hvn02 umswitcht wenn der einser down wäre und da alle PVEs immer das komplette Datacenter zeigen ist damit die GUI abgesichert :)

Und das pve... Zertifikat des HAproxy kommt natürlich auch via ACME aber auf der Sense ;) -

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Du meinst die PVE Nodes also der Hypervisor selbst?

Ja, deine NUCs.

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Und das pve... Zertifikat des HAproxy kommt natürlich auch via ACME aber auf der Sense ;)

Stimmt, Du nutzt ja Cloudflare. :)

Cool, komme dann nochmal auf Euch/Dich zurück, ein schneller Versuch heute morgen ging irgendwie krachen. -

Jup seit der Einführung von gesonderten API Keys für eigene Zonen kann man das recht schön kontrollieren.