Proxmox, ceph, zfs, pfsense и все-все-все - часть 1

-

Привет.

Про KVM, Proxmox VE, ZFS, Ceph etc.

>>Часть 2<<

Proxmox VE

Proxmox VE Documentation https://pve.proxmox.com/pve-docs/

Proxmox. Полное руководство. 2е изд. http://support.mdl.ru/MasteringProxmox.2ed/content/index.html

Proxmox. Полное руководство. 3е изд. (ожидается перевод) http://onreader.mdl.ru/MasteringProxmox.3ed/content/index.html

Книга рецептов Proxmox http://onreader.mdl.ru/ProxmoxCookbook/content/index.html

Полная виртуализация. Базовая коммерческая редакция: Proxmox-freeNAS-Zentyal-pfSense http://onreader.mdl.ru/VirtualizationComplete/content/index.html

Proxmox install on NVMe ssd intel 10gig nic ups nut rootdelay ntp postfix vlan smartmontools pci passthrough iommu https://nguvu.org/proxmox/proxmox-install/

Proxmox - Indie IT Wiki http://wiki.indie-it.com/wiki/Proxmox

Script to install Proxmox 5.x and 6.x on a Dedicated Hetzner Server https://schaal-it.com/script-to-install-proxmox-5-x-and-6-x-on-a-dedicated-hetzner-server/

Configure the Proxmox firewall https://www.kiloroot.com/secure-proxmox-install-sudo-firewall-with-ipv6-and-more-how-to-configure-from-start-to-finish/

Rename a node(франц.) https://memo-linux.com/proxmox-renommer-un-noeud/

Proxmox and let's encrypt with acme https://blog.chasefox.net/proxmox-lets-encrypt/

Virtualisierung (нем.) https://deepdoc.at/dokuwiki/doku.php?id=virtualisierung

Differential backups patch - https://github.com/ayufan/pve-patches

Installing Docker on Proxmox https://www.reddit.com/r/Proxmox/comments/ifeni2/bestsolid_tut_for_installing_docker_on_promox_62/

Install Docker with Rancher and DockerUI webgui on a Proxmox or Debian https://www.solaris-cookbook.eu/linux/debian-proxmox-install-docker-with-rancher-and-dockerui-webgui/

Proxmox performance monitoring zfs watch iostat glances netdata pidstat iotop blkid udevadm http://blog.jason.tools/2019/01/disk-perf-issue.html

Display CPU temperature in Proxmox VE dashboard with lm-sensors http://everun.top/helpcenter/others/pve-tips-2.html

Статьи proxmox pfsense sr-iov (кит.) https://pvecli.xuan2host.com/

Proxmox mit Grafana überwachen https://www.bachmann-lan.de/proxmox-mit-grafana-ueberwachen/

Извлечение конкретной директории из бекапа Proxmox (*.vma.lzo) для VDS c FreeBSD https://www.flynet.pro/ru/blog/izvlechenie-konkretnoy-direktorii-iz-bekapa-proxmox-vmalzo-dlya-vds-c-freebsd

OSFMount - Mount Disk Images & Create RAM Drives img dd E01 VHD ISO bin vmdk https://www.osforensics.com/tools/mount-disk-images.html

Настраиваем сеть в Proxmox Virtual Environment https://interface31.ru/tech_it/2019/10/nastraivaem-set-v-proxmox-ve.html

Fix Proxmox VE (PVE) noVNC/console not working in iOS/iPhone/iPad Safari/Web Browser https://dannyda.com/2020/05/15/how-to-fix-proxmox-ve-pve-novnc-console-not-working-in-ios-iphone-ipad-safari-web-browser-etc-failed-to-connect-to-server/

Backup and Restore Proxmox VE host using UrBackup https://dannyda.com/2020/05/28/how-to-backup-proxmox-ve-host/

Run Wireguard over port 443 in an unprivileged LXC container behind a nginx reverse proxy with DNS security https://www.reddit.com/r/Proxmox/comments/katrzd/how_to_run_wireguard_over_port_443_in_an/

Proxmox PVE Host Config Backup Script https://gist.github.com/mrpeardotnet/6bdc4b504f43ce57fa7eaee96d376edf

Efficient backup of lxc containers in Proxmox https://it-notes.dragas.net/2020/10/06/efficient-backup-of-lxc-containers-in-proxmox/

Use watchdog to reboot stuck servers

https://it-notes.dragas.net/2018/09/16/proxmox-enable-and-use-watchdog-to-reboot-stuck-servers/

https://tompaw.net/proxmox-vm-watchdogs/

https://forum.proxmox.com/threads/i6300esb-watchdog-in-windows-help-needed.37990/

https://github.com/dmitriypavlov/pve-watchdog

Экономим место на дисках вирт. машин https://pve.proxmox.com/wiki/Shrink_Qcow2_Disk_Files , https://www.belug.de/howtos-using_trim_inside_virtual_machines.html

Turnkeylinux templates lxc http://mirror.turnkeylinux.org/turnkeylinux/images/proxmox/

Запускаем kubernetes внутри LXC https://habr.com/post/420913/

Инкрементальный бэкап в Proxmox VE с помощью VBR (Veeam Backup&Replication) incremental backup https://selectel.ru/blog/proxmox-veeam-backup/

All-In-One: Proxmox + OpenMediaVault или ещё одна идея для домашнего NAS https://habr.com/ru/post/328048/

Proxmox VE + NextCloud + OpenMediaVault + OpenLDAP https://becoder.org/diynas-pve-nextcloud-omv4-openldap-3/

Sécurisons le login sous Proxmox par fail2ban email https://jeedom-facile.fr/index.php/2018/12/05/securisation-du-login-sous-proxmox/

*Post install script (convert from LVM to ZFS, create ZFS from devices, creates default routes to allow for extra ip ranges to be used, create private mesh vpn/network using Tinc) https://github.com/extremeshok/xshok-proxmox

Proxmox: Automatische Snapshots einrichten https://techlr.de/proxmox-automatische-snapshots-einrichten/

Automatic snapshot tool for Proxmox VE https://github.com/EnterpriseVE/eve4pve-autosnap

A set of Proxmox VE scripts that aids with suspend/resume and cpu pinning https://github.com/ayufan/pve-helpers

proxmox ve tools script (debian9+ can use it) email, samba, NFS, set zfs max ram, nested virtualization, docker, pci passthrough etc https://github.com/ivanhao/pvetools

Терминальный сервер XRDP Debian 9.3 в LXC контейнере Proxmox VE 5.1 https://a-katyrev.blogspot.com/2018/08/debian-93-lxc-proxmox-ve-51-1.htm

Setting Up Proxmox with Shared Storage over Infiniband https://tech-jungle.com/setting-up-proxmox-with-shared-storage-over-infiniband/

Быстрая сеть в домашней лаборатории или как я связался с InfiniBand https://habr.com/ru/post/529906/

Использование недорогих 10/40 Гбит/с сетевых адаптеров с интерфейсом HP FlexibleLOM https://habr.com/ru/post/529732/

Настройка NUT для управления ИБП с нескольких серверов ups apc usb windows debian

https://blog.programs74.ru/how-to-installing-and-configuring-nut/Glossary of Virtualization Terms iommu acs vfio ovmf https://heiko-sieger.info/glossary-of-virtualization-terms/

What is IOMMU and why do I need it? https://heiko-sieger.info/iommu-groups-what-you-need-to-consider/

PCI passthrough via OVMF https://wiki.archlinux.org/index.php/PCI_passthrough_via_OVMF

QEMU/Guest graphics acceleration https://wiki.archlinux.org/index.php/QEMU/Guest_graphics_acceleration

GPU passthrough tutorial https://forum.proxmox.com/threads/gpu-passthrough-tutorial-reference.34303/

Single GPU passthrough with QEMU and VFIO https://github.com/joeknock90/Single-GPU-Passthrough

Running Windows 10 on Linux using KVM with VGA Passthrough https://heiko-sieger.info/running-windows-10-on-linux-using-kvm-with-vga-passthrough/

Looking Glass - an open source application that allows the use of a KVM configured for VGA PCI Pass-through without an attached physical monitor, keyboard or mouse https://github.com/gnif/LookingGlass

KVM, PCI passthrough, Looking Glass и все-все-все https://habr.com/post/433878/

Nvidia Optimus laptop dGPU passthrough https://gist.github.com/Misairu-G/616f7b2756c488148b7309addc940b28

Dell R710 with GPU Passthrough on Proxmox https://www.youtube.com/watch?v=epNvY_YKPu8

Building a 2U AMD Ryzen server (Proxmox GPU Passthrough / OBS or Xsplit in VM) http://blog.quindorian.org/2018/03/building-a-2u-amd-ryzen-server-proxmox-gpu-passthrough.html/

Разворачиваем виртуалку с Windows с пробросом виртуальной видеокарты с помощью QEMU и Intel GVT-g https://habr.com/ru/post/437270/

Как из домашнего ПК средствами виртуализации сохранить игровую систему nvidia https://habr.com/ru/post/437598/

Primary VGA passthrough in ProxMox https://techblog.jeppson.org/2019/10/primary-vga-passthrough-in-proxmox/

Enable GPU Passthrough on Proxmox VE 6.0 https://lunar.computer/posts/gpu-passthrough-proxmox-60/

NVIDIA GPU passthrough Code 43 error fix NVIDIA GPU passthrough Code 43 error fix https://techblog.jeppson.org/2019/10/proxmox-6-nvidia-gpu-passthrough-fix/

The Ultimate Beginner's Guide to GPU Passthrough (Proxmox, Windows 10) www.reddit.com/r/homelab/comments/b5xpua/the_ultimate_beginners_guide_to_gpu_passthrough/

Intel nvidia intel GPU nic network card passthrough spdk sr-iov kata containers https://github.com/kata-containers/documentation/tree/master/use-cases

Proxmox PCI(e) Passthrough in 2 minutes https://www.reddit.com/r/Proxmox/comments/lcnn5w/proxmox_pcie_passthrough_in_2_minutes/Running macOS on QEMU KVM https://github.com/kholia/OSX-KVM

Installing macOS on Proxmox https://www.nicksherlock.com/category/proxmox/

Hackintosh-KVM Guide: High Sierra+ Using QEMU’s i440fx Chipset https://passthroughpo.st/hackintosh-kvm-guide-high-sierra-using-qemus-i440fx-chipset/1C на Proxmox lxc https://habr.com/post/429172/

Cluster

Setting up an HA Cluster with Ceph Bluestore https://memo-linux.com/proxmox-5-mise-en-place-dun-cluster-ha-avec-ceph/

Proxmox 5: 2-node cluster with replicated storage https://memo-linux.com/proxmox-5-cluster-2-noeuds-avec-un-stockage-replique/

Надежное хранилище с DRBD9 и Proxmox nfs iscsi lvm https://habr.com/post/417597/

Proxmox cluster over OpenVPN tap (франц.) https://blog.zwindler.fr/2018/06/05/creation-dun-cluster-de-virtualisation-proxmox-ve-5-2-x/

Setting up a cluster between two Proxmox nodes on different networks over OpenVPN (франц.) https://memo-linux.com/proxmox-creer-un-cluster-multi-sites/

Proxmox Cluster Ceph : migration version 5 vers 6 https://memo-linux.com/proxmox-cluster-ceph-migration-version-5-vers-6/

Кластеризация в Proxmox VE https://selectel.ru/blog/proxmox-cluster/

Setting up a Proxmox VE cluster with Ceph shared storage https://medium.com/@qwonkiwow/setting-up-a-proxmox-ve-cluster-with-ceph-shared-storage-e7a4f652f321

Build a hyper-converged cluster with KVM and GlusterFS https://www.servethehome.com/building-a-proxmox-ve-lab-part-1-planning/

ansible-role-proxmox - deploys and configures Proxmox VE 5.x/6.x clusters ceph ipmi https://github.com/lae/ansible-role-proxmox

Понятно про CEPH https://www.youtube.com/watch?v=PmLPbrf-x9g

Полное руководство Ceph http://onreader.mdl.ru/MasteringCeph/content/index.html

Книга рецептов Ceph http://onreader.mdl.ru/CephCookbook/content/index.html

Ceph software defined cloud storage management solution https://croit.io/croit-production-guide

Сeph — от «на коленке» до «production» https://habr.com/ru/post/458390/

Install OpenAttic - management and monitoring system for Ceph on Proxmox https://www.facebook.com/notes/chris-hsiang/pve-44-安裝-openattic-套件/10211191515174257

Ceph: memory optimization hugepages numa https://ivirt-it.ru/ceph-memory-optimization/

Backup And Restore Ceph for Proxmox VE https://github.com/EnterpriseVE/eve4pve-barc

Разворачиваем хранилище LINSTOR для Proxmox DRBD https://habr.com/post/423101/SR-IOV

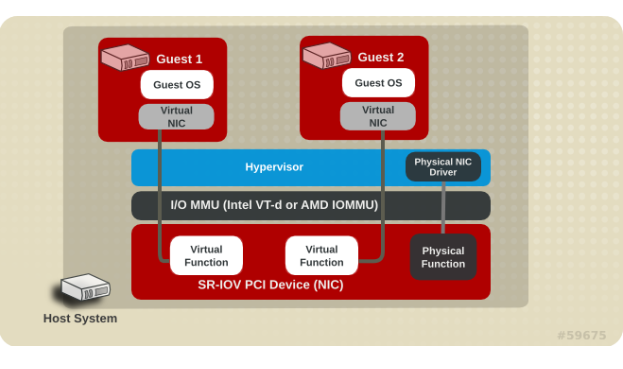

Про SR-IOV (https://habr.com/ru/post/414655/):

Про SR-IOV от RedHat:

rhelblog.redhat.com/2016/05/23/sr-iov

redhatstackblog.redhat.com/2015/03/05/red-hat-enterprise-linux-openstack-platform-6-sr-iov-networking-part-i-understanding-the-basics

redhatstackblog.redhat.com/2015/04/29/red-hat-enterprise-linux-openstack-platform-6-sr-iov-networking-part-ii-walking-through-the-implementation

Pci Passthrough и технология VT-D — это как раз аппаратный проброс реального устройства в виртуальную машину.

Требуется поддержка от процессора и материнской платы. Аналог AMD — IOMMU. При этом гостевая система считает, что к ней подключено полноценное pci устройство с соответствующей же производительностью. Помимо сети так ещё часто подключают видеокарты для игр/расчётов на виртуальной машине. Временами — raid контроллеры, когда гостю требуется полное управление дисковой подсистемой.

В простых ситуациях (и в этом посте) используют сетевой мост для связи виртуальной машины с реальным адаптером. При этом практически вся работа ложится на центральный процессор, что не очень хорошо сказывается на времени отклика при высоких нагрузках на систему.

Разница между SR-IOV и pci passthrough в том, что для первого метода требуется дополнительная поддержка конкретным устройством (сетевой картой, например). При втором методе пробросить можно что угодно (но тут уже зависит от жадности производителя — nvidia очень не любит проброс видеокарт и пытается заставить людей покупать карты серии Quadro).

...

Я бы сказал SR-IOV позволяет на одной сетевой карте создать несколько Virtual Function устройств и пробрасывать в виртуалку уже их, а не всю сетевую карту целиком.

В итоге они работают почти так же как macvlan, но силами сетевухи: отлавливая пакеты с определенным MAC-адресом. Сделать виртуальный бридж на них не получится.

...

То есть нарезать ресурсы реальной карты на несколько виртуальных машин, и при этом каждая будет почти на уровне bare-metal работать со всем этим?

...

Именно так, сами VF, без включения IOMMU можно активировать и на хостовой машине, определяться они будут как отдельное PCI-устройство.

Технология IOMMU нужна как раз для того что бы осуществить этот проброс устройства непосредственно в виртуалку.Если ваши мат. платы + cpu + сетевые адаптеры поддерживают SR-IOV (!):

http://www.osp.ru/lan/2012/05/13015724/

https://software.intel.com/en-us/articles/configure-sr-iov-network-virtual-functions-in-linux-kvm

http://blog.pichuang.com.tw/Enable-SR-IOV-on-Proxmox/

http://enricorossi.org/blog/2016/intel_sr-iov_on_Debian_Stretch/

https://forum.proxmox.com/threads/cannot-use-sr-iov-on-proxmox.27045/

Turn on intel nic SR-IOV and passthrough https://www.facebook.com/notes/chris-hsiang/pve-42-如何開啟-intel-nic-sr-iov-以及-passthrough/10209002585332379** Для "счастливых" владельцев HP Proliant поколения G8-** (G9+ вроде починили, обязательно обновить BIOS сервера до последней возможной версии) желающих пробросить GPU, raid-контроллер, сетевые адаптеры etc в ВМ и столкнувшимся с невозможностью это сделать ввиду э-э-э, особенностей серверных платформ от HP (ошибки "vfio: failed to set iommu for container: Operation not permitted" и"vfio-pci 0000:0X:YY.Z: Device is ineligible for IOMMU domain attach due to platform RMRR requirement. Contact your platform vendor" при попытке запуска ВМ )

- (Не работает) https://forum.proxmox.com/threads/tutorial-compile-proxmox-ve-5-with-patched-intel-iommu-driver-to-remove-rmrr-check.36374/

- (Работает, компиляция ядра не требуется, заменить xenial на stretch ) http://www.jimmdenton.com/proliant-intel-dpdk/

P.s. Можно загрузиться в ILO с Live CD того же Linux Mint 19.x , запустить терминал, перейти в учетку root (sudo passwd root -> два раза пароль -> su - -> пароль root) и проделать рабочую процедуру, к-ая описана выше (заменить xenial на bionic в настройках репозитория, ес-но).

Сетевые адаптеры с поддержкой SR-IOV:

http://dpdk.org/doc/nics

https://www.intel.com/content/www/us/en/support/articles/000005722/network-and-i-o/ethernet-products.html

https://www.vmware.com/resources/compatibility/search.php?deviceCategory=io (в Features выбрать SR-IOV и нажать Update and view results )P.s. Напр., Asrock AB350 Pro4 при своей достачно скромной цене (в кач-ве мат. платы для сервера) умеет и amd_iommu и sr-iov - осталось только сетевую прикупить. Более того, совсем бюджетные Biostar A320MD PRO\A320MH PRO также умееют и amd_iommu и sr-iov.

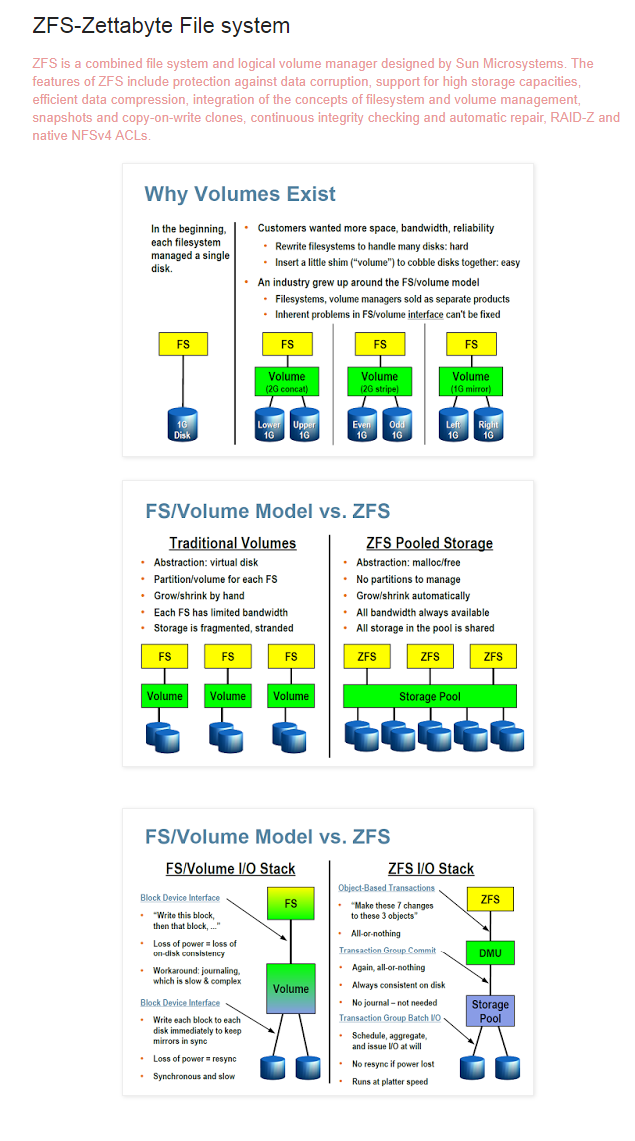

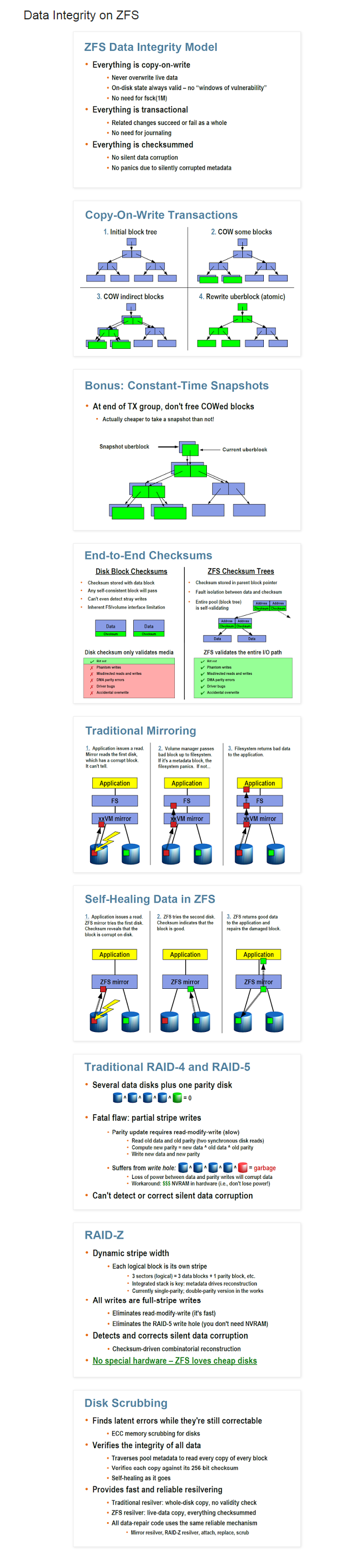

Zettabyte File System (ZFS)

ZFS: архитектура, особенности и отличия от других файловых систем https://habr.com/ru/company/mailru/blog/529516/

ZFS for Dummies https://blog.victormendonca.com/2020/11/03/zfs-for-dummies/

An Introduction to ZFS A Place to Start https://www.servethehome.com/an-introduction-to-zfs-a-place-to-start/

Slideshow explaining VDev, zpool, ZIL and L2ARC for noobs! https://www.ixsystems.com/community/threads/slideshow-explaining-vdev-zpool-zil-and-l2arc-for-noobs.7775/

Доступно про ZFS L2ARC, SLOG https://www.ixbt.com/live/data/apacer-nas-ssd-obzor-ssd-sozdannogo-dlya-ispolzovaniya-v-nas.html

Introduction to ZFS https://www.ixsystems.com/community/resources/introduction-to-zfs.111/

Мастерство FreeBSD: ZFS для профессионалов http://onreader.mdl.ru/AdvancedZFS/content/index.html

ZFS on Linux wiki https://github.com/zfsonlinux/zfs/wiki

ZFS: Read Me 1st https://blog.cadena-it.com/linux-tips-how-to/zfs-read-me-1st/

Что такое ZFS? И почему люди от неё без ума? https://habr.com/post/424651/

Преимущества и недостатки ZFS http://www.stargrave.org/ZFS-proscons.html

Features provided by ZFS преимущества http://doc.freenas.org/11/zfsprimer.html

Список литературы про NAS zfs zlog l2arc https://habr.com/post/418091/

Цикл статей о ZFS http://nas-faq.github.io/zfs/

Hardware recommendation ssd sata sas raid ashift 4k ecc memory http://open-zfs.org/wiki/Hardware

Performance tuning postgresql mysql logbias ashift ssd l2arc zil compression http://open-zfs.org/wiki/Performance_tuning

How to improve ZFS performance https://icesquare.com/wordpress/how-to-improve-zfs-performance/

ZFS: Тестируем надежность на плохих дисках https://habrahabr.ru/post/347640/

Use snapshots, clones and replication in ZFS https://www.howtoforge.com/tutorial/how-to-use-snapshots-clones-and-replication-in-zfs-on-linux/

VDev, zpool, ZIL and L2ARC for noobs https://forums.freenas.org/index.php?threads/slideshow-explaining-vdev-zpool-zil-and-l2arc-for-noobs.7775/

ZFS Configuration Part 2: ZVols, LZ4, ARC, and ZILs Explained https://passthroughpo.st/zfs-configuration-part-2-zvols-lz4-arc-zils-explained/

ZFSin: работаем с ZFS нативно под Windows https://habr.com/post/374317/

zpool FAULTED error fix repair recover https://dan.langille.org/2018/11/06/zpool-faulted-too-many-errors/

ZnapZend - open source ZFS backup with mbuffer and ssh support perl script http://www.znapzend.org/ , https://forum.proxmox.com/threads/znapzend-backup-generator-script.33309/

Удалённые инкрементные резервные копии ZFS remote incremental backup snapshot https://habr.com/ru/post/491456/

Battle testing data integrity verification with ZFS, Btrfs and mdadm+dm-integrity http://www.unixsheikh.com/articles/battle-testing-data-integrity-verification-with-zfs-btrfs-and-mdadm-dm-integrity.html

How To Create A NAS Using ZFS and Proxmox (with pictures) https://forum.level1techs.com/t/how-to-create-a-nas-using-zfs-and-proxmox-with-pictures/117375

Step by Step Install with UEFI, ZFS, SSD ZIL L2ARC cache, File Server samba raidz template https://forum.proxmox.com/threads/step-by-step-install-w-efi-zfs-ssd-cache-file-server.41619/

Install Docker on Proxmox, with ZFS, and good performance portainer turbo boost https://forum.level1techs.com/t/gigabyte-server-activity-corner-proxmox-docker-and-config-notes/167614

ZFS Sync storage to Host for Proxmox VE https://github.com/EnterpriseVE/eve4pve-zstorage

Proxmox rescue mode grub zfs repair https://pvecli.xuan2host.com/proxmox-grub-zfs/

Using ProxMox as a ZFS NAS zfs-zed email postfix sanoid snapshot ups apc nfs samba smart logwatch https://techblog.jeppson.org/2019/08/using-proxmox-as-a-nas/

*Проверить, есть ли смысл вкл. deduplication на Вашем пуле https://habr.com/ru/post/328048/#comment_10208284Recover files from ZFS snapshot of ProxMox VM https://techblog.jeppson.org/2019/01/recover-files-from-zfs-snapshot-of-proxmox-vm/

Восстановление из любого snapshot-а (а не только с последнего) https://forum.proxmox.com/threads/cloning-a-vm-from-snapshot-not-working.34247/

На пальцах:- Создать новую VM с размером hdd равным размеру клонируемой. Не запускать VM.

- Выполнить:

zfs list # просмотр списка вирт. машин zfs clone rpool/data/vm-<old-number>-disk-<number>@<snapshot-name> rpool/data/vm-<old-number>-disk-<number>-clone dd if=/dev/zvol/rpool/data/vm-<old-number>-disk-<number>-clone of=/dev/zvol/rpool/data/vm-<new-number>-disk-<number> bs=4096 zfs destroy rpool/data/vm-<old-number>-disk-<number>-cloneSMR: новая технология записи делает HDD непригодными для работы в RAID https://www.linux.org.ru/news/hardware/15692989

Потеря данных из-за несовместимости ZFS с WD SMR дисками https://www.linux.org.ru/forum/talks/15680121

Таблица моделей HDD https://www.mobibrw.com/2020/22727

SCT Error Recovery Control

Что такое на самом деле 'raid edition' для жёстких дисков https://geektimes.ru/post/92701/

Enabling CCTL/TLER https://b3n.org/best-hard-drives-for-zfs-server/

SCT Error Recovery Control in RAID drives https://rolandschnabel.de/blog/?p=75

Checking for TLER, ERC, etc. support on a drive https://forums.freenas.org/index.php?threads/checking-for-tler-erc-etc-support-on-a-drive.27126/

Linux Software RAID and drive timeouts http://strugglers.net/~andy/blog/2015/11/09/linux-software-raid-and-drive-timeouts/

Т.е. если вы собираете zfs raid-z1*2**3* массив, то вкл. вышеописанного поможет сократить время для восстановления,

если же собираетесь использовать zfs raid-0*1**10*, то вкл. не нужно.Open vSwitch (OVS)

Open vSwitch — программный многоуровневый коммутатор с открытым исходным текстом, предназначенный для работы в гипервизорах и на компьютерах с виртуальными машинами.

Основные возможности коммутатора:

Учёт трафика, в том числе проходящего между виртуальными машинами с использованием SPAN/RSPAN, sFlow[en] и Netflow.

Поддержка VLAN (IEEE 802.1q).

Привязка к конкретным физическим интерфейсам и балансировка нагрузки по исходящим MAC-адресам.

Работа на уровне ядра, поддержка существующих возможностей Linux по работе в качестве моста.

Поддерживает Openflow для управления логикой коммутации.

Помимо режима на уровне ядра, с меньшей производительностью open vSwitch может работать и с правами пользователя (вне ядра).Основные области применения:

Замена обычных bridgetools.

Использование в составе Xen Server, Xen Cloud Platform, KVM, VirtualBox, QEMU, ProxMox (начиная с 2.3)

QoS, GRE-туннелирование, индивидуальные политики для виртуальных машин, а также возможность агрегации портов с распределением нагрузки.Open vSwitch Command Reference https://docs.pica8.com/display/PICOS2111cg/PicOS+Open+vSwitch+Command+Reference

Open vSwitch - Proxmox VE https://pve.proxmox.com/wiki/Open_vSwitch

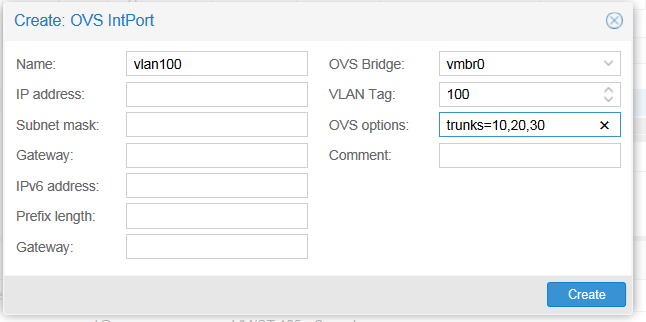

Примеры создания vlan, bond, bridge, OVSIntPort https://forum.pfsense.org/index.php?topic=139045.0, https://forum.proxmox.com/threads/vlan-tag.38051/

OpenVswitch vlan trunk gre vxlan span rspan mirror lacp bonding https://gns3.com/news/article/containers-in-gns3-series-advanc

Описание openvswitch fake bridge internal port bond https://www.altlinux.org/Etcnet/openvswitch

Проброс VLAN-ов через интернет openvpn OVSIntPort https://habrahabr.ru/post/239729/

Security Onion & Proxmox SPAN Port mirror https://beyondtheory.io/blog/virtualization/security-onion-proxmox/--> Использование Open vSwitch в Proxmox:

Установка:

apt-get clean; apt-get update; apt-get install -y openvswitch-switchПереключение на ovs в gui :

1. Delete the vmbr0 (Linux bridge) # линк с Proxmox не потеряется, не бойтесь

2. Create vmbr0 as ovs-bridge with your IP/MASK/Gateway and Bridge ports [ethX] # вместо ethX - имя вашего физ. интерфейса

3. Reboot.По https://blog.scottlowe.org/2012/10/04/some-insight-into-open-vswitch-configuration/ поясню немного :

Добавить ВМ в определенный vlan можно в GUI, указав нужный VLAN Tag в настройках сети ВМ. Это аналог untag\access порта на железном свитче. Задействовать назначенный выше vlan можно без перезагрузки ВМ, просто выкл\вкл сетевой интерфейс непосредственно в ВМ.Если хотите, чтобы ВМ находилась в опред. vlan и при этом могла "слушать" трафик из др. vlan-ов, то https://forum.proxmox.com/threads/ovs-bridge-with-vlans.27280/

Или создать еще один OVS IntPort в GUI. В настройках указать необходимые вам параметры для VLAN (и не только для VLAN). И прицепить созданный интерфейс к ВМ. Но после создания OVS IntPort понадобится перезагрузка всего хоста.

Также можно объединять интерфейсы (bonding), настраивать балансировку\отказоустойчивость (LACP) - https://blog.scottlowe.org/2012/10/19/link-aggregation-and-lacp-with-open-vswitch/

По ссылке Proxmox. Полное руководство. 2е изд есть глава, посвященная Ovs - http://onreader.mdl.ru/MasteringProxmox.2ed/content/Ch07.html

https://forum.proxmox.com/threads/proxmox-ve-on-debian-jessie-with-zfs-hetzner.33429/

2-ая страница крайне интересна. Есть про удаленную установка из .iso, используя qemu и vnc. Таким образом можно устанавливать любой дистрибутив linux.Pfsense

Virtualizing pfSense on VMware vSphere/ESXi, Proxmox, Xen, KVM, Hyper-V https://www.netgate.com/docs/pfsense/virtualization/index.html

HOW TO: 2.4.0 ZFS Install, RAM Disk, Hot Spare, Snapshot, Resilver Root Drive https://forum.netgate.com/topic/112490/how-to-2-4-0-zfs-install-ram-disk-hot-spare-snapshot-resilver-root-drive

pfSense VLANs on Proxmox (исп-ся linux bridge) https://www.linuxincluded.com/pfsense-vlans-on-proxmox/Нюансы работы pfsense в Proxmox:

I've got a fresh install of 2.3.3-RELEASE-p1 (amd64), running on ovirt (kvm). My guests (only have linux guests) could ping out, but no udp or tcp.

Just selecting the "Disable hardware checksum offload" and rebooting (though I didn't check without rebooting) the pfsense instance did the trick.

I didn't need to change anything on the ovirt/kvm hypervisor - the default offload settings are in place. All guests (pfsense and the linux ones) are using virtio network drivers.

Microsoft Windows OS

Рекомендации для гостевых ОС семейства Microsoft Windows:

https://pve.proxmox.com/wiki/Windows_2008_guest_best_practices

https://pve.proxmox.com/wiki/Windows_2012_guest_best_practices

https://www.proxmox.com/en/training/video-tutorials/item/install-windows-2016-server-on-proxmox-veVMware OS Optimization Tool - оптимизация Windows в виртуальной среде (подойдет и для proxmox) https://codebeer.ru/optimizaciya-windows-v-virtualnoj-srede/

CloneDisk – clone,backup,restore raw vhd vmdk iso imdisk http://labalec.fr/erwan/?page_id=42

Misc

->zswap

https://www.hippolab.ru/linux-zswap-dayte-mashine-shans, https://wiki.archlinux.org/index.php/Zswap , http://ru.knowledgr.com/19459262/Zswap , http://linuxoidblog.blogspot.com/2015/12/zram-zswap.html

Script for creating hybrid swap space from zram swaps, swap files and swap partitions https://github.com/Nefelim4ag/systemd-swap

Вкратце, это технология, позволяющая оптимизировать работу ядра со swap - хранилищем избыточных страниц памяти.

Включение и использование ZSWAP в Proxmox VE и любом современном дистр-ве Linux с ядром >= 3.11

Обновляемся:

apt-get clean; apt-get update; apt-get full-upgrade -y; apt-get autoremove --purge -y; apt-get autocleanПерезагружаемся:

rebootПроверяем включено ли в ядре:

cat /boot/config-$(uname) | grep -i zswapЕсли все ОК:

CONFIG_ZSWAP=yПравим GRUB :

mkdir -vp /etc/default/grub.dНа выбор:

LZ4:

echo 'GRUB_CMDLINE_LINUX_DEFAULT="$GRUB_CMDLINE_LINUX_DEFAULT zswap.enabled=1 zswap.compressor=lz4 zswap.zpool=z3fold zswap.max_pool_percent=25"' > /etc/default/grub.d/zswap.cfg

или

ZSTD:

echo 'GRUB_CMDLINE_LINUX_DEFAULT="$GRUB_CMDLINE_LINUX_DEFAULT zswap.enabled=1 zswap.compressor=zstd zswap.zpool=z3fold zswap.max_pool_percent=25"' > /etc/default/grub.d/zswap.cfg

update-grub

Вкл. модули:

cp -fv /etc/initramfs-tools/modules{,.orig}

for module in lz4 lz4_compress zstd zstd_compress z3fold

do grep -qx "${module}" /etc/initramfs-tools/modules || echo "${module}" >> /etc/initramfs-tools/modules

done

update-initramfs -u -k all

Перезагрузка:

reboot

Проверяем:

dmesg | grep -i zswap

Должно быть:

Если выбран LZ4:

...

zswap: loaded using pool lz4/z3fold

...

Для ZSTD:

...

zswap: loaded using pool zstd/z3fold

...

Получаем статистику по ZSWAP:

Статистика:

watch -n1 grep -R . /sys/kernel/debug/zswap/

Сжатие:

cd /sys/kernel/debug/zswap

watch -n1 -x perl -E "say $(cat stored_pages) * 4096 / $(cat pool_total_size)"

Текущие настройки:

grep -R . /sys/module/zswap

Прим. Касаемо строки zswap.zpool=z3fold. По умолчанию на данный момент в linux испол-ся zbud в кач-ве memory allocator. Он обкатан и надежен и работает на любом "железе", но появился более эффективный z3fold:The zpool parameter controls the management of the compressed memory pool, it is by default set to zbud. With the zbud data allocator, 2 compressed objects are stored into 1 page which limits the compression ratio to 2 or less. The superior z3fold allocator allows up to 3 compressed objects by page. The compression ratio with z3fold typically averages 2.7 while it is 1.7 for zbud.

Однако, следует помнить, что компрессия требует вычислительных мощностей. И чем сильнее сжатие, тем выше требования к "железу".Turn off Spectre and Meltdown vulnerability patch in Windows and Linux https://heiko-sieger.info/low-2d-graphics-benchmark-with-windows-10-1803-kvm-vm/

Remove old kernel packages script on Linux distros or Proxmox (для proxmox 6+ уже не актуально - автоматом сохраняются 2 последние версии ядра для загрузки) https://github.com/algodelinux/purge-old-kernels https://enavas.blogspot.com/2017/01/modificado-purge-old-kernels-para.html

Guide to crossflashing LSI\Avago 9211 HBA Dell H200 PERC Fujitsu D2607 IBM M1015 and variants IT or IR mode https://forums.freenas.org/index.php?resources/detailed-newcomers-guide-to-crossflashing-lsi-9211-hba-and-variants.54/

LSI RAID Controller and HBA Complete Listing Plus OEM Models https://forums.servethehome.com/index.php?threads/lsi-raid-controller-and-hba-complete-listing-plus-oem-models.599/

Flashing firmware and BIOS on LSI SAS HBAs https://www.broadcom.com/support/knowledgebase/1211161501344/flashing-firmware-and-bios-on-lsi-sas-hbas

Flashing LSI HBA\IBM ServeRAID M1015 to IT mode or IR Mode https://geeksunlimitedinc.wordpress.com/2017/02/16/flashing-lsi-hba-to-it-mode-or-ir-mode/->FOG Project

FOG можно использовать:

- как систему резервного копирования, создавая по расписанию снимки разделов , установив клиента и разворачивать эти снимки по сети на др. компьютеры в сети (у меня с помощью sysprep и FOG созданы эталонные образы Windows, к-ые я разворачиваю по сети);

- как систему P2V\V2V\V2P-миграции;

- загружать по сети все, что может загружаться по сети - windows, linux, антивирусные live-cd (https://www.comss.ru/list.php?c=bootcd) , ПО для брендового серверного оборудования HP, Dell , загружать тонкие клиенты etc.

An Introduction to Free-Open Source Ghost (FOG) https://linuxhint.com/introduction-to-free-open-source-ghost/

Install FOG Server on Ubuntu https://www.ceos3c.com/sysadmin/install-fog-server-ubuntu-server-16-04-lts-ultimate-guide-virtualbox/

Create a Generalized Windows 10 Image (sysprep) and Deploy it with FOG Server https://www.ceos3c.com/sysadmin/create-generalized-windows-10-image-deploy-fog-server/Установка Proxmox по сети (PXE\iPXE\HTTP) с помощью FOG Project (https://fogproject.org/) - a free open-source network computer cloning and management solution (некий аналог WDS (Windows Deployment Services))

Скрипт модификации образа Proxmox VE для загрузки по сети https://github.com/morph027/pve-iso-2-pxe

Меню FOG-а для Proxmox :kernel http://${fog-ip}/fog/isos/proxmox/linux26 vga=791 video=vesafb:ywrap,mtrr ramdisk_size=16777216 rw quiet splash=silent initrd http://${fog-ip}/fog/isos/proxmox/initrd.iso.img bootЗагрузка c .iso в FOG Project:

Add an ISO entry in the iPXE Boot menu https://memo-linux.com/fog-ajouter-une-entree-dans-le-menu-ipxe-boot/

Booting MDT 2013 LiteTouch with FOG https://forums.fogproject.org/topic/6284/booting-mdt-2013-litetouch-with-fog/25

ISO's in FOG PXE https://community.spiceworks.com/topic/997567-iso-s-in-fog-pxe \ https://youtu.be/KYp-XVPxg3I

Advanced Boot Menu Configuration options https://wiki.fogproject.org/wiki/index.php/Advanced_Boot_Menu_Configuration_options

Include any ISO in the FOG Bootmenu https://wiki.fogproject.org/wiki/index.php?title=Include_any_ISO_in_the_FOG_Bootmenu -

Спасибо за популяризацию Proxmox.

Из мануала по вашим ссылкам:

Proxmox VE сам по себе свободен для применения. Не существует абсолютно никаких платежей включенных в загрузку простого образа ISO и установки полнофункционального кластера Proxmox без оплаты лицензий или подписок.

С официального сайта:

COMMUNITY

Starting out

€ 5,83/month (per CPU)Отказ от подписки с точки зрения разработчиков допустим?

-

Отказ от подписки с точки зрения разработчиков допустим?

Все строго добровольно. Хотите платную поддержку и сверх быструю реакцию на баги - платите. Нет? Пользуйте просто так.

P.s. Вот "увидивили". Был на 146% уверен, что уж вы-то, ув. pigbrother, точно KVM "тискали" :'(

-

Первый тестовый виртуальный домен поднимал в далеком 2001 году на PIII (Vmware Workstation). ;),

Winows NT DC, рабочие станции Windows NT и 98, выход в интернет через RRAS с диалапом…Сейчас в продакшн используется ESXi - выбор руководства. Мы посовещались и оно решило ;).

С KVM за довольно долгую карьеру столкнуться, как ни странно, так и не пришлось. Сейчас же хочу покрутить для собственного интереса.Что порекомендуете - сразу 5.0 или начать с 4.4?

-

5-ку, ес-но. После установки - сразу обновить.

Если в будущем в продакшн соберетесь, то использовать ZFS raid от 2-ух (raid1), а лучше - 4 диска (raid10). Zfs raid идет из коробки и в самом начале установки конфигурируется.

-

Proxmox поддерживает nested virtualization? Хочу попробовать в ESXi. Нет под рукой свободного полноценного железа.

UPD.

Можно, так же как и для остальных гипервизоров, запускаемых в ESXi.

https://imanudin.net/2015/03/04/how-to-install-proxmox-nested-on-vmware-esxi-full-support-openvz-kvm/Все это исключительно для тестов, нормальной работы от такого мутанта никто не ждет.

-

Nested virtualization (вложенная виртуализация, т.е. возможность запускать гипервизор в гипервизоре) на Proxmox:

https://pve.proxmox.com/wiki/Nested_Virtualization

https://medium.com/@alexander.bazhenov/установка-vmware-esxi-внутри-proxmox-d5778b5a97a1 -

Миграция с других гипервизоров (локально).

Migrate VMWare ESXi Virtual Machines to Proxmox KVM with LVM-Thin Logical Volumes https://www.sysorchestra.com/2017/03/16/migrate-vmware-esxi-virtual-machines-to-proxmox-kvm-with-lvm-thin-logical-volumes/

Migrate from Xenserver to Proxmox https://techblog.jeppson.org/2018/01/migrate-xenserver-proxmox/

https://www.reddit.com/r/homelab/comments/625i4p/tutorial_convert_vulnhub_vms_for_proxmox/

Небольшой how-to.

Внимание! Формат raw - это т.н. "сырой" формат образов дисков. Перед дальнейшими операциями убедиться в наличие

свободного места.Подключаемся по SFTP к Proxmox. В Win это можно сделать с пом. WinSCP или FAR.

Забрасываем образ(ы) диска(ов), к-ые мы хотим подкинуть к ВМ в предварительно созданную временную папку.

Прим. Если у вас ova-образ - сперва распаковываем

tar -xvf disk.ovaКонвертируем (на примере vmware .vmdk)

qemu-img convert -p -O raw disk.vmdk disk.rawСмотрим размер получившегося

ls -ahlCоздаем через gui ВМ с диском(-ми) не меньшего размера. ВМ не запускать!

Смотрим что у нас получилось (у вас путь к образам дисков может быть другой)

ls -al /dev/zvol/rpool/data/Разворачиваем образ диска в диск ВМ

dd if=/path/to/file/disk.raw of=/dev/zvol/ZFS-Pool-Name/vm-XYZ-disk-X

ZFS-Pool-Name и vm-XYZ-disk-X изменить на своиПосле

qm rescanUpd2.

Короткий вариант. Проверил - работает.

qemu-img convert -p -O raw disk.vmdk /dev/zvol/ZFS-Pool-Name/vm-XYZ-disk-X

ZFS-Pool-Name и vm-XYZ-disk-X изменить на свои

qm rescanЗапускаем ВМ. Проверяем.

Upd3.

Специально для тех, кто переходит с MS Hyper-V на Proxmox (KVM):Подкидываем **vhdx-**образ по SFTP во временную папку на Proxmox.

Далее повторяем ранее описанное (т.е., создаем через gui ВМ с диском необх. размера, но не вкл. её! )

Команда для конвертации:

qemu-img convert -p -O raw disk.vhdx /dev/zvol/ZFS-Pool-Name/vm-XYZ-disk-X

ZFS-Pool-Name и vm-XYZ-disk-X изменить на свои

qm rescanЗапускаем ВМ. Проверяем.

Upd4.

И для догадливых (типа меня, ага 8))

Аналогично описанному выше (только наоборот ;)) можно конвертировать zfs-диски Proxmox-а во все самые распространненные форматы:Сперва выкл. ВМ, конечно.

VHD\VHDX (Hyper-V)

qemu-img convert -p -O vhdx /dev/zvol/ZFS-Pool-Name/vm-XYZ-disk-X /path/to/file/disk.vhdx

ZFS-Pool-Name , vm-XYZ-disk-X и /path/to/file/ изменить на своиОстальные форматы https://docs.openstack.org/image-guide/convert-images.html

P.s. Также имеется возможность миграции\конвертирования по сети используя netcat, dd, pv, gzip\pigz\bzip2, ssh и

SystemRescueCD https://pve.proxmox.com/wiki/Migration_of_servers_to_Proxmox_VEТак что, добро пожаловать в мир открытого ПО. Для тех кто еще не решился )

Миграция Windows 2000 с динамическими дисками dynamic disc

Дано:

Старый сервер с Windows 2000 Server на программном raid1 из 2-ух дисков. На сервере живет оч. важное для клиента ПО.Задача:

(Бережно) перенести в Proxmox VE (KVM)Проблема:

- Linux ничего "не знает" о динамических дисках Windows, что не дает возможность использовать "в лоб" Clonezilla и Partclone для миграции локально или по сети.

- Windows 2000 не имеет в своем составе службу Volume Shadow Copy, что не позволяет использовать, напр., Disk2vhd для промежуточной миграции в vhd(x) и дальнейшего переноса на PVE.

Решение:

Нам понадобятся Clonezilla Live, Gparted Live, драйверы на сетевой адаптер Intel e1000.- Записать на CD\DVD образ Clonezilla live

- Скачать с сайта Intel и сохранить на раб. стол КЛОНИРУЕМОЙ файлы PROWMI.exe, PRO2K.exe для установки драйверов на виртуальный сет. адаптер Intel e1000

- Создать вирт. машину (ВМ) типа Windows 2000 с размером hdd НЕ МЕНЬШЕ, чем hdd клонируемой.

- Загрузиться с Clonezilla live на ФИЗИЧЕСКОЙ до момента "Start Clonezilla or enter login shell" и выбрать Enter_shell

3.1. (Опционально) Сменить пол-ля на root: sudo passwd root -> ввести 2 раза пароль -> su - и ввести придуманный ранее пароль - Загрузиться с Clonezilla live на ВИРТУАЛЬНОЙ до момента "Start Clonezilla or enter login shell" и выбрать Enter_shell

4.1. (Опционально) п.3.1. - Узнать и запомнить IP адрес на ВИРТУАЛЬНОЙ: ip a s

- Узнать и запомнить имя клонируемого диска на КЛОНИРУЕМОЙ: fdisk -l

- Узнать и запомнить имя диска, на к-ый будет перенесена инф-ция на ВИРТУАЛЬНОЙ: fdisk -l

- На ВИРТУАЛЬНОЙ ввести в терминале: sudo nc -w120 -vvnlp 19000 | sudo cat > /dev/sdX, где sdX - имя диска из п.7 и нажать Enter

- На КЛОНИРУЕМОЙ ввести в терминале: sudo pv /dev/sdX | sudo nc -vvn X.X.X.X 19000, где sdX - имя диска из п.6, X.X.X.X - IP адрес из п.5 и нажать Enter

- По завершние клонирования выкл. КЛОНИРУЕМУЮ.

- Перезагрузить ВИРТУАЛЬНУЮ.

- Установить на ВИРТУАЛЬНОЙ драйверы сетевой карты Intel E1000: 1. PROWMI.exe, 2. PRO2K.exe

- Важно! Откл. в настройках сетевой карты все, что касается Offload.

- Для избавления от динамического диска:

- добавить еще один диск в ВИРТУАЛЬНУЮ

- загрузиться с Gparted live

- скопировать партиции со старого на новый диск

- выключить ВМ

- отсоединить старый диск

- загрузиться с нового

- в случае проблем со стартом ОС загрузиться в Консоль восстановления с диска Windows 2000 и

пофиксить командами fixboot, fixmbr

-

Using Terraform and Cloud-Init to deploy and automatically monitor Proxmox instances https://yetiops.net/posts/proxmox-terraform-cloudinit-windows/

Encrypting Proxmox VE 6: ZFS, LUKS, systemd-boot and Dropbear https://tactical-documentation.github.io/post/proxmoxve6-zfs-luks-systemdboot-dropbear/

ZFS RAIDZ luks disk encryption script https://www.reddit.com/r/Proxmox/comments/ijpuv8/zfs_raidz_luks_disk_encryption_script/Мигрируем удаленно.

Прим. Примеры использования pv - http://linux-notes.org/utilita-pv-progress-bar-dlya-konsol-ny-h-utilit-v-unix-linux/

Предупреждение. Все ниже описанное вы делаете на свой страх и риск. Внимательно проверяйте какие диски копируете и куда принимаете. Крайне желательно иметь резервные копии данных.

И так. Как сказал один оч. известный и достойный Человек: "Поехали!"

Качаем на принимающей и отдающей сторонах SystemRescueCD (http://www.system-rescue-cd.org/).

Принимающая сторона:

На Proxmox создаем ВМ с размером диска как у отдающей стороны.

Загружаемся с SystemRescueCD в эту ВМ.

Настраиваем сет. параметры (net-setup имя-интерфейса) или получаем их по dhcp. Проверить полученные\настроенные сет. параметры - ip a sНа отдающей стороне:

Загружаемся с SystemRescueCD.

Настраиваем сет. параметры (net-setup имя-интерфейса) или получаем их по dhcp. Проверить полученные\настроенные сет. параметры - ip a sЗапускаем на принимающей стороне:

nc -w10 -vvnlp 19000 | pigz -5 -dfc | cat > /dev/disk-name, где :-w10 - время ожидания данных в сек. на приним. стороне (меняется на ваше усмотрение).

19000 - номер порта, к-ый слушает netcat и принимает на него данные от отдающей стороны (меняется на ваше усмотрение)

pigz -5 - степень сжатия (меняется на ваше усмотрение)

disk-name - имя диска внутри ВМ (меняете на свое)Считаем до трех и запускаем на отдающей стороне:

pv /dev/disk-name | pigz -5 -fc | nc -vvn remote-server-ip 19000, где:disk-name - имя диска, к-ый вы хотите передать (узнается по fdisk -l)

pigz -5 - степень сжатия (меняется на ваше усмотрение)

remote-server-ip - ip-адрес\имя удаленного сервера-приемника

19000 - номер порта удаленного сервера-приемникаВсё. Скрещиваем пальцы, чтобы линк между отдающей и принимающей сторонами не упал и ждем окончания процесса.

После удачного окончания выкл. ВМ на принимающей стороне. Извлекаем в gui из вирт. привода SystemRescueCD и пробуем загрузиться.Пример с SSH (кому необходима секьюрность):

Принимающая сторона:

Создаем ВМ с размером диска как у отдающей стороны.

Загружаемся с SystemRescueCD в эту ВМ.

Настраиваем сет. параметры (net-setup имя-интерфейса) или получаем их по dhcp. Проверить полученные\настроенные сет. параметры - ip a s

Смотрим какие диски у нас есть - fdisk -l. Запоминаем\записываем имя нужного нам диска.

Более ничего на принимающей стороне делать\запускать не надо.На отдающей стороне:

Загружаемся с SystemRescueCD.

Настраиваем сет. параметры (net-setup имя-интерфейса) или получаем их по dhcp. Проверить полученные\настроенные сет. параметры - ip a s

Запускаем команду:

pv /dev/disk-name | pigz -5 -fc | ssh remote-server-ip "cat > /dev/disk-name", где :disk-name - имя диска на принимающей стороне, к-ое мы внимательно выбрали и запомнили ранее

remote-server-ip - ip\имя примающей стороныОжидаем удачного окончания процесса передачи. После выкл. ВМ на принимающей стороне. Извлекаем в gui из вирт. привода SystemRescueCD и пробуем загрузиться.

-

Обновил шапку.

-

а кто расскажет, какое преимущество у zfs перед ufs ?

это какое странное достижение. Слижком уж не специфичное для фаервола. -

а кто расскажет, какое преимущество у zfs перед ufs ?

это какое странное достижение. Слижком уж не специфичное для фаервола.https://www.reddit.com/r/PFSENSE/comments/76cmjv/advantages_andor_disadvantages_zfs/

Применительно к pfSense на одном диске -

устойчивость к пропаданию питания, например. UFS крайне этого не любит

возможность работать со снапшотами, как в VM.Статья, которая, может быть, заинтересует ув. werter:

http://jrs-s.net/2016/05/09/testing-copies-equals-n-resiliency/ -

Доброе.

@derwin:а кто расскажет, какое преимущество у zfs перед ufs ?

это какое странное достижение. Слижком уж не специфичное для фаервола.В шапке есть картинки. Нагляднее некуда.

-

вы не поняли суть вопроса. Можно сравнивать жареную куропатку с боингом.

А зачем оно (ZFS) для фаервола?

чтобы логи хранить в отказоустойчивом пуле ?? смешно….

вот вам в топку http://2gusia.livejournal.com/7545.html -

Причем тут логи? Речь идет обо всей ОС в данном случае.

Пример? Легко.

Перед обновлением пф делаете снепшот (вот так http://linux.cpms.ru/?p=8931). Криво встало обновление ? Не работают пакеты, к-ые работали до обновления ? Что же делать?Звонить в Спортлото!

Да просто откатиться с пом. сделанного ранее снепшота ::)Вот от вас, ув. derwin, таких откровенно глупых вопросов я не ожидал.

-

что то я не вижу гуя по управлению zfs,а значит всё равно звонить сергею брину.

у меня до 2,4 итак всё было на снапшотах на уровне vmware. Мне мозги пропарило обновление - сейчас откатился до 2,3,4 и нет проблем.werter

фишка zfs это блочное управление и отказоусточивость за счёт проца + памяти. У меня в филиальных бордерах до недавнего времени вообще флешки стояли и я горя не знал! сдохла - вставь резервную… спасибо 2,4 - теперь заказал SSD на 60гб.....

я себе в будущем году мож прикуплю сервак с полкой под 300-дисковый zfs пул. Но это NAS сервер, а не пакетный фаервол!!!!PS: 2.4 меня вообще в тоску вгоняет.... мало того, что удалили radius2 из репо, дык ещё и с 2.3.4 запретили качать пакеты.... это какой то сплошной фейспалм.

-

что то я не вижу гуя по управлению zfs,

Гуй точно будет. Для снэпшотов он и не шибко нужен - сделал снэпшот в CLI\восстановил снэпшот в CLI.

У меня как-то регулярно пропадало электричество, UFS при этом ведет себя крайне ненадежно. Не зря в 2.4 сделали для опции выключения - перезагрузить и запустить fsck.

Учитывая что уже большая часть программных роутеров ,фаерволов итд устанавливаются на VMУ такого решения полно как сторонников, так и противников. Я - не сторонник.

Имел случай проверить свою правоту.И никто не заставляет ZFS использовать, более того - по умолчанию 2.4 ставится по прежнему на UFS.

-

я в первый раз поставил zfs где то в 2009 году вместе с проектом FreeNAS. Секс был просто адовый. Падение производительности - ужасное.

Когда развалился массив - я не смог сделать равном счётом ни-че-го. -

я в первый раз поставил zfs где то в 2009 году вместе с проектом FreeNAS. Секс был просто адовый. Падение производительности - ужасное.

Когда развалился массив - я не смог сделать равном счётом ни-че-го.Не наговаривайте. Для IT-индустрии 8-9 лет - это как для человечества 100. Как паровой котел и АЭС.

-

я в первый раз поставил zfs где то в 2009 году вместе с проектом FreeNAS. Секс был просто адовый. Падение производительности - ужасное.

Когда развалился массив - я не смог сделать равном счётом ни-че-го.Не наговаривайте. Для IT-индустрии 8-9 лет - это как для человечества 100. Как паровой котел и АЭС.

я по первому высшему инженер-котельщик-атомщик ;)

Работал по специальности, всё видел и делал