Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Also gestern war Ruhe, kein Kick. Komm jetzt langsam weiter mit dem freigeben der Ordner.

Was ist da genau der Sinn und wo liegt der Ordner der freigegeben ist? Warum nicht einfach als bspw. NFS shared folder einbinden?

Los, make my Day.

Moment, muss das andere Laptop anwerfen.

-

So das hat bei mir aktuell super funktioniert:

Credits: Das war aus einem Github GIST - ich denke dem hier:

https://gist.github.com/whiskerz007/53c6aa5d624154bacbbc54880e1e3b2a## Proxmox VE Community installieren # Disable Commercial Repo sed -i "s/^deb/\#deb/" /etc/apt/sources.list.d/pve-enterprise.list apt update # Add PVE Community Repo echo "deb http://download.proxmox.com/debian/pve $(grep "VERSION=" /etc/os-release | sed -n 's/.*(\(.*\)).*/\1/p') pve-no-subscription" > /etc/apt/sources.list.d/pve-no-enterprise.list apt update # Remove nag screen for homelab use echo "DPkg::Post-Invoke { \"dpkg -V proxmox-widget-toolkit | grep -q '/proxmoxlib\.js$'; if [ \$? -eq 1 ]; then { echo 'Removing subscription nag from UI...'; sed -i '/data.status/{s/\!//;s/Active/NoMoreNagging/}' /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js; }; fi\"; };" > /etc/apt/apt.conf.d/no-nag-script apt --reinstall install proxmox-widget-toolkitDer letzte Punkt ist der Knackpunkt. Also die beiden Zeilen. Die eine richtet ein Post-Invoke ein, der theoretisch jedes Mal nach einem package Update vom Widget Toolkit ausgeführt wird. Also nach Installation/Update sollte der dann getriggert werden. Bei einer aktuellen Version dann einfach nochmal den APT mit --reinstall der zweiten Zeile ausführen, dadurch wird das Paket nochmals drüberinstalliert und der Trigger ausgelöst und der JS Nagscreen entfernt.

Prinzipiell bin ich nicht gegen sowas, die wollen ja mit dem Support auch was Sinnvolles anfangen, aber für ein Homelab, wo ich definitiv nur rumspiele und teste, macht es eher wenig Sinn, dass ich da eine Subscription kaufen werden (wir haben ja eine auf Arbeit) zumal ich da gerade ja Bleeding Edge Pakete testen will ;)

-

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Was ist da genau der Sinn und wo liegt der Ordner der freigegeben ist? Warum nicht einfach als bspw. NFS shared folder einbinden?

Habe paar HDDs im Gehäuse und einige LW gemounted für versch. Scenarien, Backup, Datengrab für Family, kleines RAID für Mediafiles, usw..., alles auf dem Host. Bevor ich mich komplett auf KVM oder VMs whatever einschiesse, und alles in Container verschwinden lasse, soll der Zugriff auf die Shares vorhanden sein. Ist ja auch nur die Mediaserver-VM, die das braucht, und die Backupserver-VM die benötigt ein Share und das funzt schon.

Zu NFS, eigendlich egal, welches Protokoll genutzt wird. Ein NFS-Server ist eh vorhanden, wollte es nur anders hin bekommen, NFS oder SMB wäre Plan B und C.

Danke für den Link, @JeGr , muss gleich ackern, schaue heute Abend mal rein.

PS:

Die VMs mucken gelegendlich, wenn sie über die GUI gestoppt oder rebootet werden, liegt an der .lock Datei. Nervt ein bisschen. Bei Dir auch?So, erstmal wech...

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Zu NFS, eigendlich egal, welches Protokoll genutzt wird. Ein NFS-Server ist eh vorhanden, wollte es nur anders hin bekommen, NFS oder SMB wäre Plan B und C.

Ahso na dann :)

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Die VMs mucken gelegendlich, wenn sie über die GUI gestoppt oder rebootet werden, liegt an der .lock Datei. Nervt ein bisschen. Bei Dir auch?

Bislang nicht

Bin aber auch noch nicht zu viel gekommen. Und neustarts oder reboots mache ich eigentlich wann immer es geht in der VM/Container selbst. Schon allein damit die Prozesse alles ordentlich mitbekommen. Oldschool halt ;) -

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Die VMs mucken gelegendlich, wenn sie über die GUI gestoppt oder rebootet werden, liegt an der .lock Datei.

Den Guest Channel hast du hinzugefügt und den Agent in der VM installiert?

Ansosnten wird das über ACPI gemacht, was nicht immer zum Erfolg führt. -

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

So das hat bei mir aktuell super funktioniert:

Credits: Das war aus einem Github GIST - ich denke dem hier:

https://gist.github.com/whiskerz007/53c6aa5d624154bacbbc54880e1e3b2aJau, hat funktioniert, danke. :)

Zum Thema NFS Freigaben:

Ja, kannst du mounten im Datacenter, aber nur als Plattform für die Images, Clones, usw, nicht als richtige Freigabe von Ordnern. Oder übersehe was, k. A..@viragomann said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Den Guest Channel hast du hinzugefügt und den Agent in der VM installiert?

Bei der VM nicht, danke. :)

Beim Rest war es installiert, da klappte es auch.

So, der Mediaserver funzt, jetzt kann der/die? :) Node weiter laufen. Den Rest hole ich nach und nach auf den Host, das hat keine Eile.

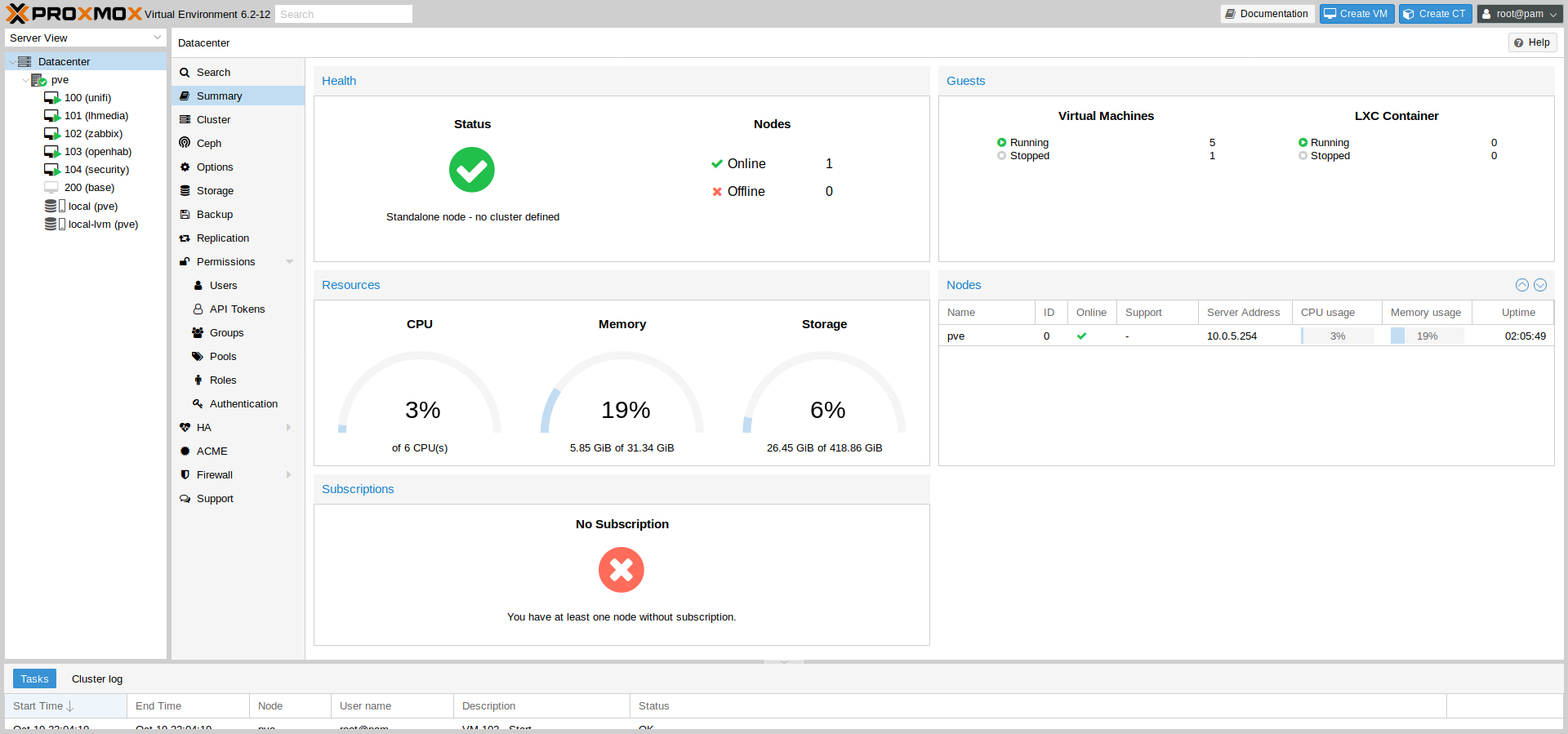

Hier ein Pic von 5 laufenen VMs:

Edit:

Moinsen.

Looft doch nicht wie es soll, nfs verträgt sich nicht mit dem 9p. Sind erst die Ordner vom host in dem Guest System gemountet, startet der NFS Server unter Guest nicht. Erst NFS Server starten und dann die händisch Hostordner mounten, das klappt. :(Das ist doch wieder alles mit der heissen Nadel gestrickt hier.

-

Ich komm da jetzt eher zu arg aus der Virtualisierungs-Ecke mit VMware, Xen und Co. von früher, aber:

warum nicht hergehen, eine VM oder Container erstellen mit einer kleinen Hauptplatte und dann einer zusätzlichen "Platte" die dann freigegeben wird per NFS? Da kann man IMHO sicherlich nen ext4 o.ä. Image einbinden, was die VM dann einhängen und per NFS den anderen Containern freigeben kann. Und wenn die NFS VM/Container aus ist, kann mans notfalls auch auf dem Host selbst mounten weils ein einfaches ext4 image ist. Ich hab das noch irgendwie im Hinterkopf dass das gehen müsste. Ich bin da nämlich nicht so der Fan, dass VMs oder Container "ausbrechen" dürfen und direkt an den Host ran dürfen. Am Ende bekommen sie da irgendwie ne Shell und können ausbüchsen - nene ;) So würde ichs versuchen zu lösen aber ob/wie das jetzt auf die schnelle mit Proxmox geht müsste ich auch nachsuchen. Leider momentan zu wenig Zeit mit Nacharbeit durch Krankheit und Co.

-

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Ich komm da jetzt eher zu arg aus der Virtualisierungs-Ecke mit VMware, Xen und Co. von früher, aber:

warum nicht hergehen, eine VM oder Container erstellen mit einer kleinen Hauptplatte und dann einer zusätzlichen "Platte" die dann freigegeben wird per NFS? Da kann man IMHO sicherlich nen ext4 o.ä. Image einbinden, was die VM dann einhängen und per NFS den anderen Containern freigeben kann.Die Container oder VMs brauchen nicht miteinander quatschen, bis auf den Mediaserver braucht keiner Zugriff auf den Host. Eventuell noch der Backupserver, dem kann man virtuell was zuweisen, das ist nicht das Problem.

Proxmox und ich sind noch nicht so dicke, als dass alles komplett auf Virtual umgeswitched wird. Das Backup und Restore wird Tage dauern, nur um Proxmox zu testen viiiiel Aufwand. :)

Ziehst ja nach dem ersten zwei Dates auch nicht gleich bei der Braut ein.

Fange ja bei Null an, bin jetzt soweit, dass ein Container den Mediaserver und NAS übernimmt. Da sind 3 Shares gemountet und damit können die Kodiboxen befeuert werden. Mit einer VM klappte nur ein Share zu mounten. Mehr geht hier aktuell nicht, wer was dazu sagen kann, wie mehrere gemountet werden kann, bitte.

Aktuell über smb, da nfs keine virtuellen Shares verteilen kann, nur physikalische Devices wie HDDs oder optische LWe etc. Mit Samba geht es, warum, keine Ahnung.Leider bin Ich nicht in der Lage, im Container die PCIe Satkarte anzusprechen, Sehe unter dmesg was, sieht aber aus wie die Einträge vom Host. Bleibt nur eine VM mit durchgereichter PCIe Karte. Ob das funzt, keine Ahnung.

Soweit die Lage, Jens. Und, wie war deine Woche so?

-

Nabend.

So, ein kleines Feedback.

Die Mediaserver VM greift nun auf mehrere Shares vom Host zu. Die Sat>IP Server VM mit der durchgereichten Sat-Karte looft, pumpt die Aufnahmen auf ein gemeinsamen Ordner, wo der Mediaserver darauf zugreifen kann. Die anderen kleinen VMs sind so gut wie konfiguriert, kann jetzt nach und nach die anderen Buden abschalten. :)

Hab auch langsam die Fresse dick.

@JeGr

Die Nodes unter PVE können sich per acme und Letsencrypt Zertifikate erstellen lassen, schon zum laufen bekommen? -

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Die Nodes unter PVE können sich per acme und Letsencrypt Zertifikate erstellen lassen, schon zum laufen bekommen?

Du meinst die PVE Nodes also der Hypervisor selbst? Ja hab ich. Meine haben sich beide als hvn01/hvn02 ein Zert ausgestellt :) Zusätzlich läuft davor noch ein HAproxy mit Prio auf hvn01 der aber auf hvn02 umswitcht wenn der einser down wäre und da alle PVEs immer das komplette Datacenter zeigen ist damit die GUI abgesichert :)

Und das pve... Zertifikat des HAproxy kommt natürlich auch via ACME aber auf der Sense ;) -

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Du meinst die PVE Nodes also der Hypervisor selbst?

Ja, deine NUCs.

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Und das pve... Zertifikat des HAproxy kommt natürlich auch via ACME aber auf der Sense ;)

Stimmt, Du nutzt ja Cloudflare. :)

Cool, komme dann nochmal auf Euch/Dich zurück, ein schneller Versuch heute morgen ging irgendwie krachen. -

Jup seit der Einführung von gesonderten API Keys für eigene Zonen kann man das recht schön kontrollieren.

-

So, Domain besorgt, bei Cloudflare registriert, ACME auf dem Node konfiguriert, Zack, Zertifikate da.

Jetzt die Frage, wie bekommen die VMs in den Genuss der Zertifikate? Habe alle Subdomains mit aufgeführt bei der Zertifizierungerstellung, nur müssen die Websites der VMs auf den Node zugreifen, oder wie muss ich mir das vorstellen? PVE hat ja einen Proxy laufen mit den Zertifikaten. Damit verteilt es die auch, oder?

Ach ja, irgendwann war kein Zugriff per IP (SSH oder HTTP) auf den VMs möglich, nur per Konsole über die Node. Nach einem Neustart des PVE-Server ging es kurzzeitig. Habe die Gäste dann komplett auf dhcp umgestellt, seitdem ist Ruhe. Dennoch seltsam irgendwie.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Jetzt die Frage, wie bekommen die VMs in den Genuss der Zertifikate?

Warum müssen sie das?

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Habe alle Subdomains mit aufgeführt bei der Zertifizierungerstellung

Was meinst du damit? Ein Zertifikat mit allen Namen erstellt?

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

PVE hat ja einen Proxy laufen mit den Zertifikaten.

Was für nen Proxy? PVE hat m.W. per default gar nüscht laufen. Außer dass er selbst Zertifikate für seine WebUI und Komponenten nutzt.

Verstehe das Setup bzw. den Wunsch noch nicht :)

-

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Verstehe das Setup bzw. den Wunsch noch nicht :)

Moinsen.

Hab mich komplett verrannt, aber so was von. :)

Nach der Erstellung des Zertifikates auf der Node erstellte PVE ein pveproxy-ssl.pem, und dieses "proxy" in dem Wort liess mich im glauben, PVE stellt Zertifikate seinen Gästen zur Verfügung. Doof, oder?

Doof, oder?

Egal, kommen die Zertifikate anders her. Werde aber mit dem ACME und HA-Proxy auf der Sense irgendwie nicht warm, gehören nicht in eine Firewall imho. Eventuell gibt es andere Lösungen, den Proxy muss ja nicht pfSense bereit stellen.

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Jetzt die Frage, wie bekommen die VMs in den Genuss der Zertifikate?

Warum müssen sie das?

Eigentlich nicht, ein Gast hat eine Weboberfläche, da wo der Log-Server und bald Zabbix looft. Der Rest werkelt headless im Hintergrund. Und nichts muss sich nach draussen präsentieren.

-

@mike69 said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Doof, oder?

Nö nur mißverständlich :)

Werde aber mit dem ACME und HA-Proxy auf der Sense irgendwie nicht warm, gehören nicht in eine Firewall imho.

Oh ja doch. Nur weil HAproxy per se ein mächtiger Loadbalancer ist, ist er auch gleichzeitig für 2.5 der Ersatz für "relayd" und den internen LB. Außerdem ist er voll IPv6 fähig und hilft dabei IP4->IP6 zu übersetzen (bspw.).

Er gehört ggf. nicht zum Core - agreed, deshalb ists ein Paket - aber zur Firewall würde ich ihn definitiv NICHT missen wollen. Und einfache Setups sind mit den Templates problemlos möglich.

Eigentlich nicht, ein Gast hat eine Weboberfläche, da wo der Log-Server und bald Zabbix looft. Der Rest werkelt headless im Hintergrund. Und nichts muss sich nach draussen präsentieren.

Wenn nicht nicht draußen:

- Interne CA ausrollen und installieren und damit Zertifikate ausstellen

- Genauso acme Zertifikate ausrollen eben mit acme.sh auf der VM selbst. Geht genausogut und man kanns jederzeit auch extern nutzen

- HAproxy auf pfSense nutzen mit Acme mit eingebunden und auf den/der VM einfach self signed von den Produkten lassen, die die oft mitbringen. Gleiche Vorteile wie 2 aber ich hab alles zentral im Griff und in der Übersicht.

Ich nehm da gern 3, man kanns aber auch mit 2 machen. 1 wird zunehmend schwieriger weil da Apple Gedöns reingrätscht und Zerts länger als 398 Tage eh nicht mehr akzeptiert werden. Das unterminiert dann den Sinn von internen CAs bei denen man Zertifikate und CA Lifetimes von 5-10 Jahren gesetzt hat und gut ;)

-

Da muss ich mich wohl oder übel damit auseinander setzen müssen....tun. :)

Zumal Deutsche Glasfaser gerade bei uns anklopft. Wenn das klappt, ist eh alles IPv6, dann muss ich es tun.

@JeGr

Es wird auf Punkt 3 hinauslaufen. Melde mich beizeiten, die kalten Bastelwintertage kommen bald.Gruß

-

Hallöle.

Da Proxmox aktuell zufriedenstellend läuft, kommen jetzt die ersten Gehversuche zum Thema ZFS und RAID-Z1. Beim erstellen fällt das nutzbare Datenvolumen auf, welches im Gegensatz zu mdadm echt gering ausfällt. 3 x 8TB HDDs als RAID-Z1 ergibt gerade mal roundabout 10500 GiB, was für den Gast zu nutzen übrig bleibt.

Beim klassischen SoftRAID sind es knapp 14000 GiB. Bunkert sich das ZFS Filesystem soviel für sich, um geschmeidig zu laufen?Zumal ZFS es nicht erlaubt, sein RAID zu erweitern.

Wie ist Eure Meinung dazu?

Gruß, Mike

-

Zumal ZFS es nicht erlaubt, sein RAID zu erweitern.

Noch nicht:

https://freebsdfoundation.org/blog/openzfs-raid-z-online-expansion-project-announcement/

Ist aber schon länger in der Mache.Beim klassischen SoftRAID sind es knapp 14000 GiB. Bunkert sich das ZFS Filesystem soviel für sich, um geschmeidig zu laufen?

Bin ich tatsächlich überfragt gerade weil nicht so in der Materie drin. Wäre tatsächlich keine schlechte Frage bei einem "Crossover Talk" mit Leuten aus der OPNsense Ecke, da ist u.a. jemand dabei, der (lustigerweise ebenfalls aus KA/DE) sich schon sehr lange und intensiv mit TrueNAS/FreeNAS beschäftigt und da auch ggf. mit dran geschraubt hat, den man ggf. dazu mal anhauen könnte ;) Synergie und so :D

Aber könnte mir vorstellen, dass das irgendeine Einstellung von ZFS ist um es evtl. für Ersatz einfacher zu machen. Also ein Schwellenwert der pro Platte angenommen wird damit man auch kleinere und größere als Ersatz verwenden kann. Bei knapp 14 bei softraid ist meist ja gar keine error margin mit drin. Bei guten Raid Controllern oder MD/LVM ist da meist auch so 1-2% mit drin weil es bei den Platten bei der Rechnung auch an Hand der verbauten Technik/Plattern Unterschiede gibt. 10500 ist dann schon wenig, aber kann auch sein, dass da Platz für Metadaten, Caching und sonstiges sowie eben error margin mit reingerechnet wurden.Weiß es wie gesagt nicht genau, aber gibt einige (gute) Gründe :) Leider traue ich bei drehendem Metall nichts mehr unter Z2 aber da bin ich eigen (und leidig kampferprobt).

-

@JeGr said in Hardware zur Virtualisierung von mehreren Instanzen: Allgemeine Fragen und Lösungen.:

Leider traue ich bei drehendem Metall nichts mehr unter Z2 aber da bin ich eigen (und leidig kampferprobt).

Ja ok, da bleibt bei 4 HDDs kaum was über.

Habe spasseshalber 2 8TB HDDs jeweils als ZFS auf ein ZFS Filetyp und als EXT4 auf ein Linux Filetyp erstellt. Da stehen dann 6,8 TB ZFS der 7,2 TB EXT4 gegenüber.

Zur Ergänzung hier der Vorgang von letzter Woche:

-Mit 3 x 8TB HDDs als RAID-Z1 ein ZPool errichtet, ergaben knapp 14,2 TiB.

-Unter Datacenter / Storage aus dem Pool ein Laufwerk (Storage) errichtet (schreibt man das so?)

-Dem Gast eine Hard Disk auf dieser Storage hinzugefügt (Raw Disk Image) da bleiben nur 10,5 TiB über.Ob es anders oder besser geht, kein Plan. Schätze, die User mit RAID im privaten Umfeld sind rar gesät. Wer dazu was sagen kann, nur zu.

Gruß, Mike